❤️ 如果你也关注 AI 的发展现状,且对 AI 应用开发感兴趣,我会每日分享大模型与 AI 领域的开源项目和应用,提供运行实例和实用教程,帮助你快速上手AI技术!

🥦 AI 在线答疑 -> 智能检索历史文章和开源项目 -> 尽在微信公众号 -> 搜一搜:蚝油菜花 🥦

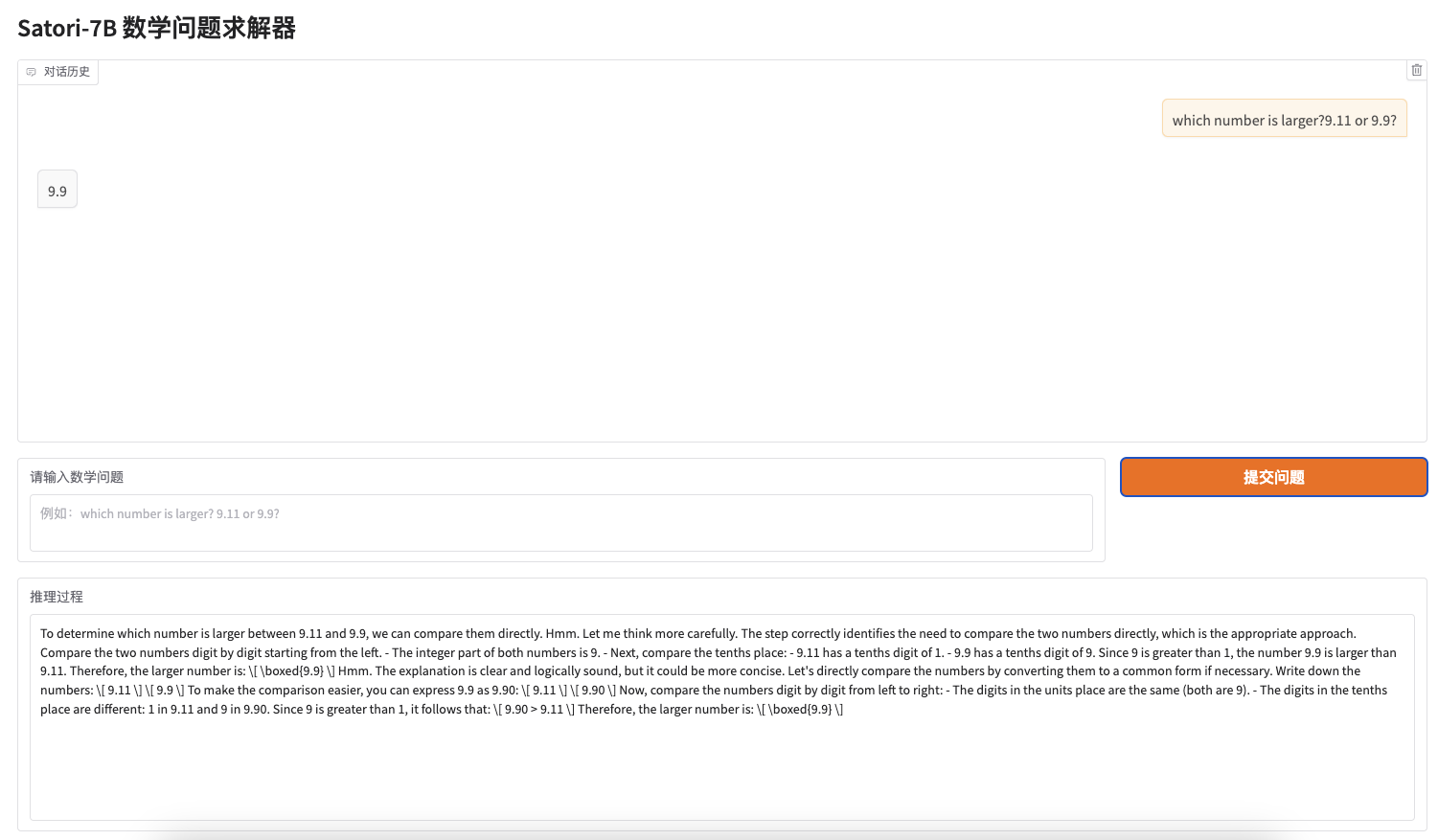

Satori-7B-Round2-WebUI

Satori-7B-Round2 模型参数量仅 7B 就在数学推理能力上超越 70B 和一众小型模型,MIT与哈佛基于行动-思维链(COAT)机制训练的 Satori-7B-Round2 推理模型。

本项目基于 Satori-7B-Round2 推理模型和 Gradio API 提供了一个友好的 Web UI,方便快速部署实例后立即体验 Satori-7B-Round2 模型的推理能力。

Satori-7B-Round2-WebUI 的运行界面

一键部署 Satori-7B-Round2-WebUI

通过镜像一键部署实例

1. 使用该镜像创建实例

首先,在镜像发布页可以查看到我制作完成并分享到平台的实例镜像,通过右侧的使用该镜像创建实例可以快速创建一个实例。

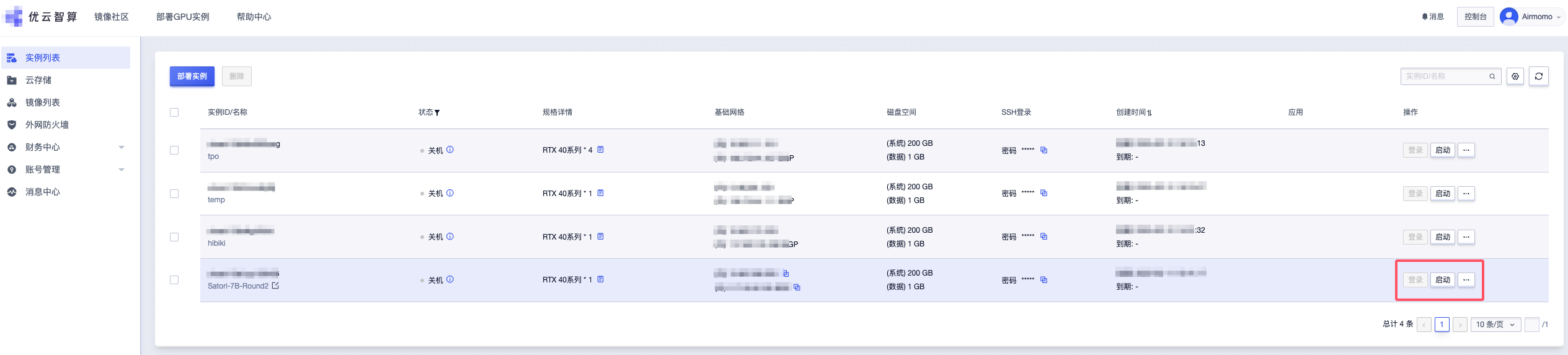

2. 部署GPU实例

Satori-7B-Round2 模型的参数量为 7B 大小,这里推荐配置 4090 单卡。也可按需选择配置后再立即部署。

3. 启动实例

稍等片刻后,实例就会自动创建并启动,通过查看实例列表可查看实例的运行状态,并支持随时关闭或启用。

实例同时提供了一个 JupyterLab 应用作为交互式开发环境,它提供了更现代化和灵活的用户界面,方便我们继续后续的步骤。

4. 运行 WebUI 服务

启动实例后,你可以通过 JupyterLab 应用的终端输入以下命令来快速启动服务:

python gradio_app.py --share --host 0.0.0.0 --port 7860

WebUI 服务默认通过 7860 端口进行访问,镜像已经配置了端口转发,你可以直接通过公网访问。

- 参数说明:

| 参数 | 说明 | 示例命令 |

|---|---|---|

--port | 指定应用程序运行的端口号 | python gradio_app.py --port 7860 |

--share | 允许通过公网访问应用程序 | python gradio_app.py --share |

--host | 指定应用程序绑定的主机地址 | python gradio_app.py --host 0.0.0.0 |

镜像已内置模型,运行时会检测本地模型路径,不用再重新配置和下载模型,程序会自动启动推理引擎和 Gradio App 并输出访问地址,大致如下:

* Running on local URL: http://0.0.0.0:7860

* Running on public URL: https://62c32ff6bbd7ca4d2f.gradio.live

Satori-7B-Round2 是什么

Satori-7B-Round2 是由MIT、哈佛大学等机构研究者推出的 7B 参数大型语言模型,专注于提升推理能力。基于 Qwen-2.5-Math-7B,Satori 通过小规模的格式微调和大规模的增强学习实现了先进的推理性能。

该模型引入了行动-思维链(COAT)机制,通过特殊的元动作标记引导模型进行推理。Satori 在数学推理和跨领域任务中表现出色,展现了优异的泛化能力。

Satori-7B-Round2 的核心功能

- 自回归搜索能力:Satori 通过自我反思和探索新策略,能进行自回归搜索,无需外部指导即可完成复杂的推理任务。

- 数学推理:Satori 在数学推理基准测试中取得了最佳成绩,展现出卓越的推理能力。

- 跨领域任务:除了数学领域,Satori 在逻辑推理、代码推理、常识推理和表格推理等跨领域任务中也表现出色,具有很强的泛化能力。

- 自我反思与纠错能力:Satori 在推理过程中能自我反思并进行自我纠错,提升了推理的准确率。

- 强化学习优化:采用行动-思维链(COAT)机制和两阶段训练框架,包括小规模格式调优和大规模自我优化,主要依靠强化学习(RL)实现先进的推理性能。

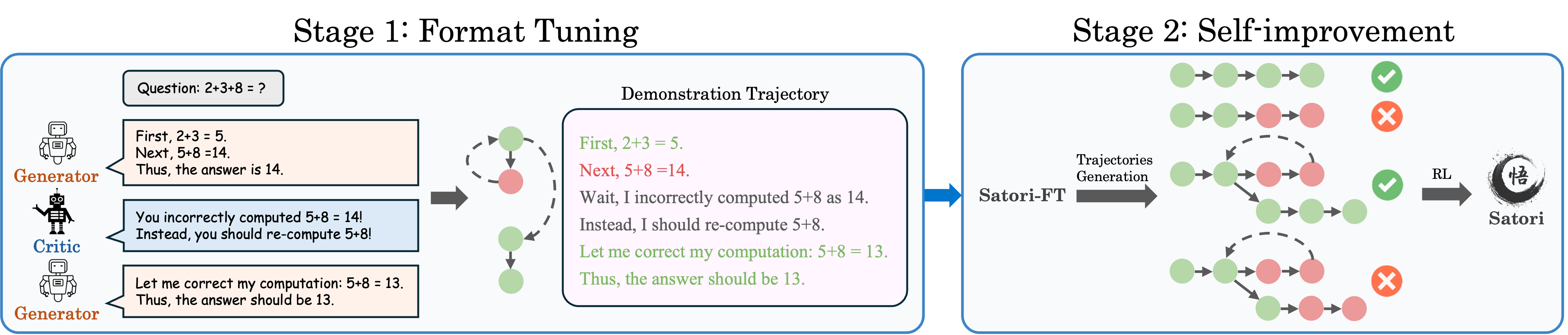

Satori-7B-Round2 的技术原理 —— COAT

-

行动-思维链(COAT)推理:

- 继续推理(<|continue|>):鼓励模型生成下一个中间步骤。

- 反思(<|reflect|>):验证之前的推理步骤是否正确。

- 探索替代方案(<|explore|>):识别推理中的漏洞并探索新的解决方案。

-

两阶段训练框架:

- 小规模格式调优阶段:在少量推理轨迹示例的小数据集上进行微调,使模型熟悉 COAT 推理格式。

- 大规模自我优化阶段:通过强化学习(RL)优化模型性能,采用重启与探索(RAE)技术,提升模型的自回归搜索能力。

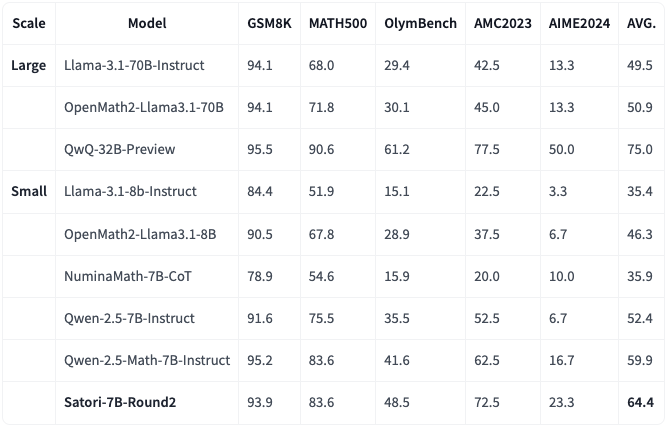

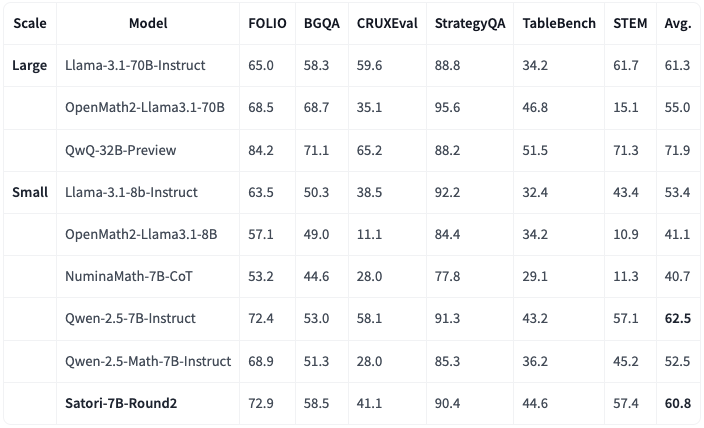

Satori-7B-Round2 的数学推理能力基准

在数学推理中,Satori-7B-Round2 的表现已达到 SOTA 性能,并优于使用相同基础模型(Qwen-2.5-Math-7B)的 Qwen-2.5-Math-7B-Instruct。甚至大幅度超越了 Llama-3.1-70B-Instruct 这个参数量比它还大十倍的模型。

Satori-7B-Round2 的通用领域推理基准

仅在数学数据集上训练的 Satori-7B-Round2 在跨多个领域外的推理基准测试中表现出强大的迁移能力,并且大幅超越了 Qwen-2.5-Math-7B-Instruct。

尽管没有在其他领域进行训练,Satori-7B-Round2 的性能与或超过了其他小型通用指令模型,与 Llama-3.1-70B-Instruct 等大型模型不相上下。

资源

- GitHub 仓库:https://github.com/Airmomo/satori-7b-round2-webui

- HuggingFace 仓库:https://huggingface.co/Satori-reasoning/Satori-7B-Round2

❤️ 如果你也关注 AI 的发展现状,且对 AI 应用开发感兴趣,我会每日分享大模型与 AI 领域的开源项目和应用,提供运行实例和实用教程,帮助你快速上手AI技术!

🥦 AI 在线答疑 -> 智能检索历史文章和开源项目 -> 尽在微信公众号 -> 搜一搜:蚝油菜花 🥦

扫码加入用户交流群

扫码加入用户交流群