ComfyUI-Wanx-T2V

WAN 2.1 是一款强大的文本到视频(T2V)生成模型,专为创建流畅、高质量的视频内容而设计。该模型提供两个版本:全尺寸14B参数版本(支持FP8精度)和轻量级1.3B参数版本,可根据不同硬件条件灵活选择

0

00元/小时

v1.0

WAN 2.1 文本生成视频模型

模型简介

WAN 2.1 是一款强大的文本到视频(T2V)生成模型,专为创建流畅、高质量的视频内容而设计。该模型提供两个版本:全尺寸14B参数版本(支持FP8精度)和轻量级1.3B参数版本,可根据不同硬件条件灵活选择。

使用教程

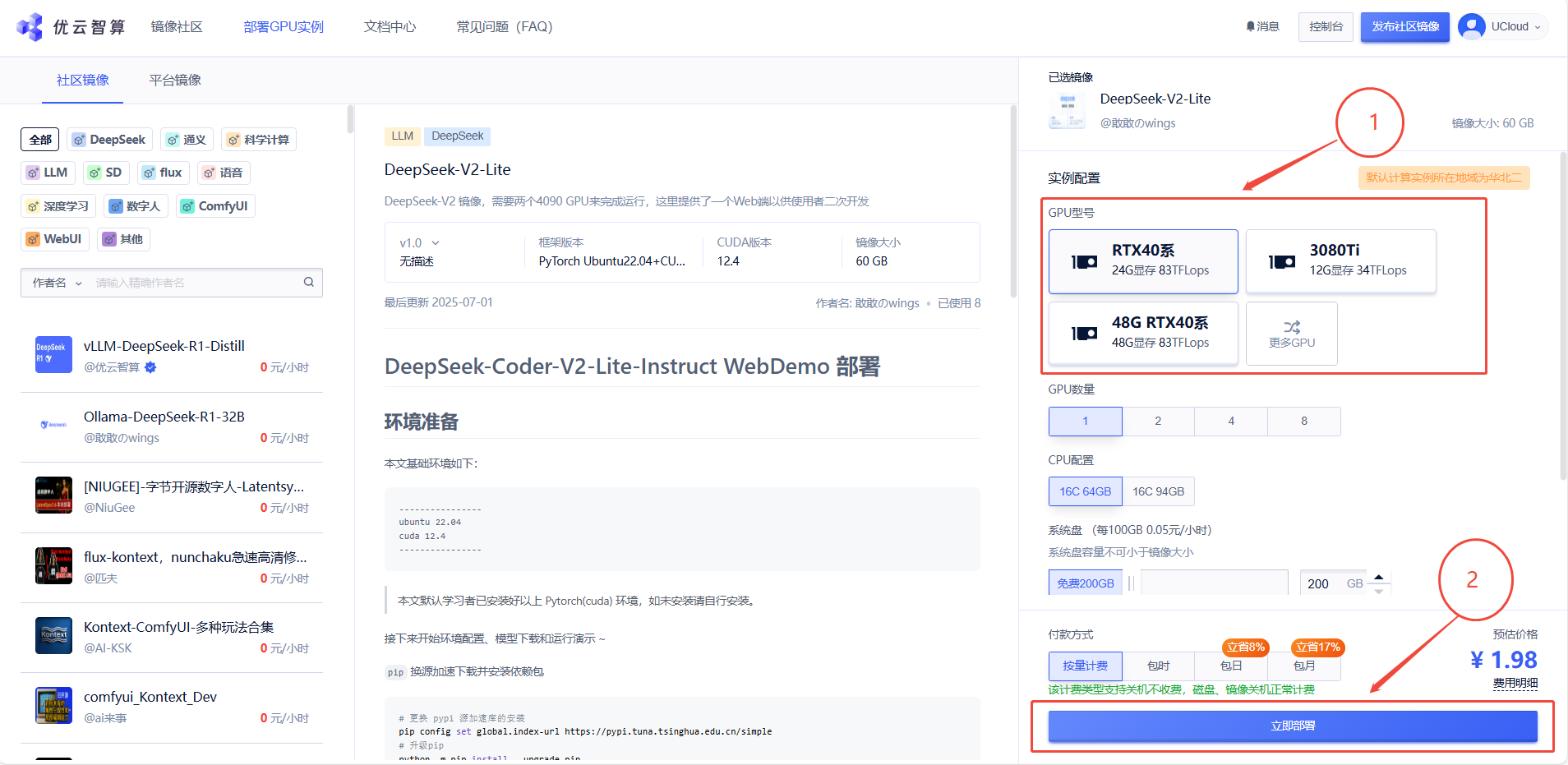

1. 先选择GPU型号,再点击“立即部署”

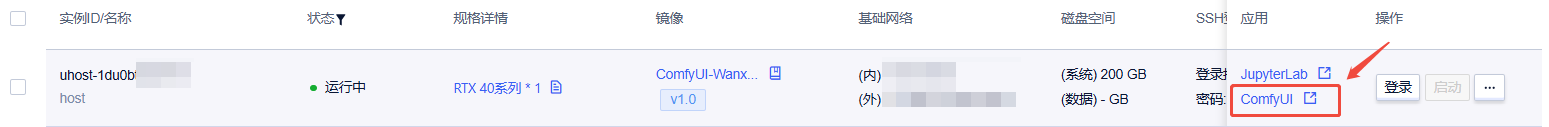

2. 该镜像支持自启动,待实例初始化完成后,在控制台-应用中打开“ComfyUI”

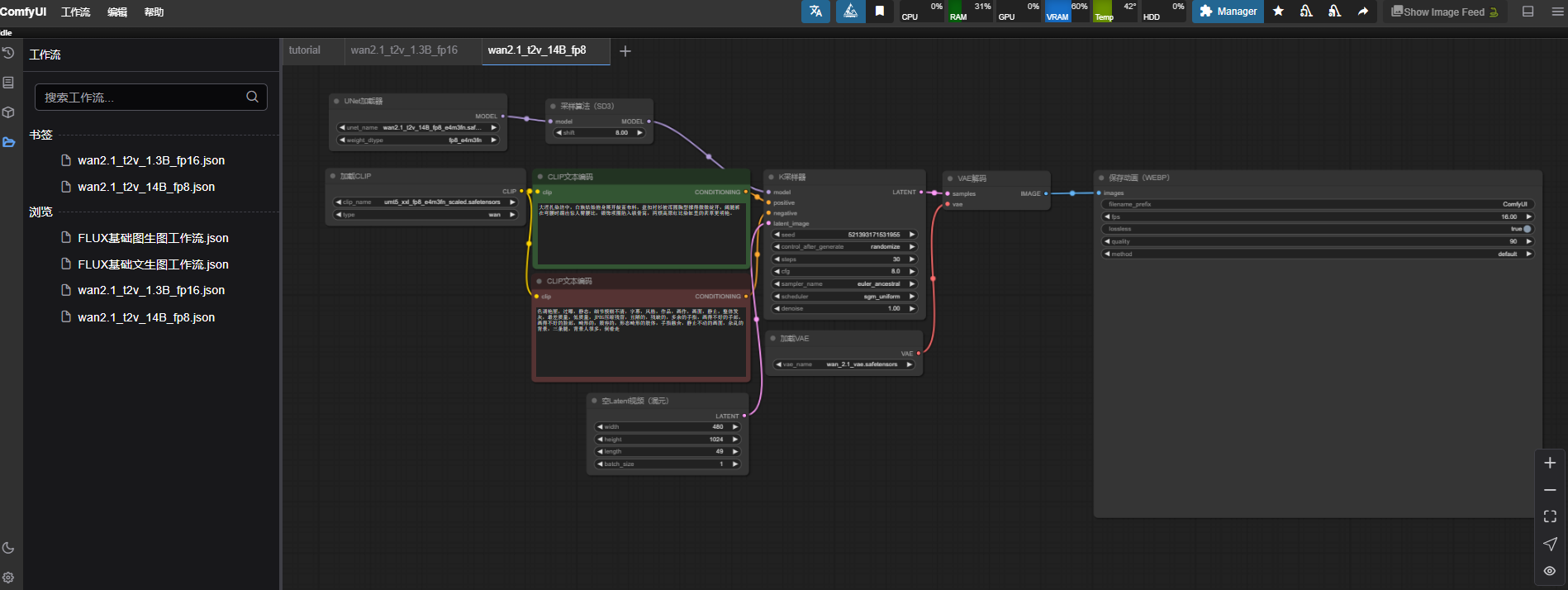

3. 成功进入ComfyUI界面如下图所示

主要特点

- 高效能生成:14B版本使用FP8精度(e4m3fn)优化,在保持质量的同时大幅减少显存占用

- 分辨率灵活:支持480×1024等多种常用分辨率

- 多帧输出:默认生成49帧视频,可根据需要调整

- 流畅过渡:专为创建连贯、自然的动态视频序列优化

- 强大文本表现:能理解并精确表现中文描述的场景、服饰和动作细节

技术规格表

| 参数 | 14B FP8版本 | 1.3B FP16版本 |

|---|---|---|

| 模型大小 | 约7GB | 约2GB |

| 显存要求 | ≥16GB | ≥8GB |

| 推荐GPU | RTX 3090/4090 | RTX 3060及以上 |

| 支持分辨率 | 480P至720P | 主要480P |

| 生成速度 | 较慢 | 较快 |

| 视觉质量 | 优秀 | 良好 |

| 提示词理解 | 全面精确 | 基础理解 |

支持分辨率参考

| 视频方向 | 推荐分辨率 | 备注 |

|---|---|---|

| 横向视频 | 1024×576 | 16:9比例,适合一般场景 |

| 竖向视频 | 480×1024 | 9:19.2比例,适合移动设备 |

| 正方形 | 768×768 | 1:1比例,适合社交媒体 |

安装要求

系统要求

- ComfyUI最新版本

- Python 3.10+

- 支持CUDA的NVIDIA GPU

模型文件

-

下载所需模型文件:

-

14B版本:

wan2.1_t2v_14B_fp8_e4m3fn.safetensors(主模型)umt5_xxl_fp8_e4m3fn_scaled.safetensors(CLIP模型)wan_2.1_vae.safetensors(VAE模型)

-

1.3B版本:

wan2.1_t2v_1.3B_fp16.safetensors(主模型)umt5_xxl_fp8_e4m3fn_scaled.safetensors(CLIP模型)wan_2.1_vae.safetensors(VAE模型)

-

-

将文件放置于ComfyUI模型目录下对应文件夹

使用参数表

| 参数类型 | 参数名称 | 推荐值 | 可调范围 | 影响 |

|---|---|---|---|---|

| 采样器 | 采样方法 | euler_ancestral | 多种算法 | 生成风格和稳定性 |

| 采样器 | 调度器 | sgm_uniform | 多种选项 | 噪声调度方式 |

| 采样器 | 步数 | 30 | 20-50 | 质量与速度平衡 |

| 采样器 | CFG Scale | 8 | 5-12 | 提示词遵循程度 |

| 采样器 | 去噪强度 | 1 | 0.5-1 | 创意自由度 |

| 视频设置 | 帧数 | 49 | 25-100 | 视频长度 |

| 视频设置 | 帧率 | 16 | 8-30 | 播放速度 |

| 视频设置 | 循环播放 | true | true/false | WEBP循环设置 |

| 视频设置 | 质量 | 90 | 50-100 | 输出文件质量 |

提示词技巧

有效的提示词结构

[地点/环境],[人物特征],[动作描述],[服装描述],[肢体语言/姿态],[光线氛围]

示例提示词

大理扎染坊中,白族姑娘俯身展开靛蓝布料,盘扣衬衫被浑圆胸型撑得微微绽开,阔腿裤在弯腰时绷出惊人臀腰比,银饰项圈陷入锁骨窝,两颊高原红比染缸里的茜草更明艳。

@Faych

镜像信息

已使用31 次

运行时长

12 H

镜像大小

80GB

最后更新时间

2025-07-14

支持卡型

RTX40系20803080Ti309048G RTX40系2080TiH20A800P40A100RTX50系V100S

+12

框架版本

CUDA版本

12.4

应用

JupyterLab: 8888

版本

v1.0

2025-07-14