OpenManus自动生成项目

这个镜像提供了一个免费的OpenManus环境,并基于ollama来快速启动一个 LLM(大型语言模型)应用程序。该项目可支持单卡运行整个项目。

0

00元/小时

v1.0

什么是 OpenManus

OpenManus 是 MetaGPT 团队推出的开源 AI Agent 复刻版 Manus,支持多种语言模型和工具链,能够执行代码、处理文件、搜索网络信息等复杂任务,具备实时反馈机制和灵活的配置选项。

如何运行 OpenManus

接下来我们将一步步介绍如何通过 Ollama 本地部署大模型,以及如何运行 OpenManus。

1.启动 Ollama 服务

待实例初始化完成后,在控制台-应用中打开“JupyterLab”;进入JupyterLab后,新建一个终端Terminal,在终端中执行以下命令以启动 Ollama 服务:

ollama serve

如图所示,Ollama 服务启动后默认运行在11434端口:

不要关闭前一个终端,再新建一个终端,运行以下命令在本地部署大模型,这里选择部署来自阿里通义的QWQ模型:

ollama run qwq

如图所示,启动后可以看到控制台出现了输入框,输入内容可以与模型完成对话并查看生成结果:

2.修改 OpenManus 的模型配置

在启动 OpenManus 服务前,我们需要配置 LLM API 的相关信息,请按照以下步骤修改配置文件:

1. 进入 OpenManus 目录:

cd OpenManus

2. 接着,需要在 OpenManus/config 目录中手动创建一个命名为 config.toml 的配置文件,也可以运行以下命令复制配置文件模版作为新的配置文件:

cp config/config.example.toml config/config.toml

3. 编辑上一步的 config.toml 文件,添加你的 LLM API 密钥并自定义设置,我这里使用的是 QWQ 模型,你可以换其他 ollama 的模型:

参考配置:

# Global LLM configuration

[llm]

model = "qwq"

base_url = "http://localhost:11434/v1"

api_key = "sk-11223344qwer"

max_tokens = 4096

temperature = 0.0

# Optional configuration for specific LLM models

[llm.vision]

model = "claude-3-5-sonnet"

base_url = "https://api.openai.com/v1"

api_key = "sk-..."

3.启动 OpenManus 服务

接下来,确保你在 OpenManus 目录下,通过运行以下命令启动 OpenManus 服务:

python main.py

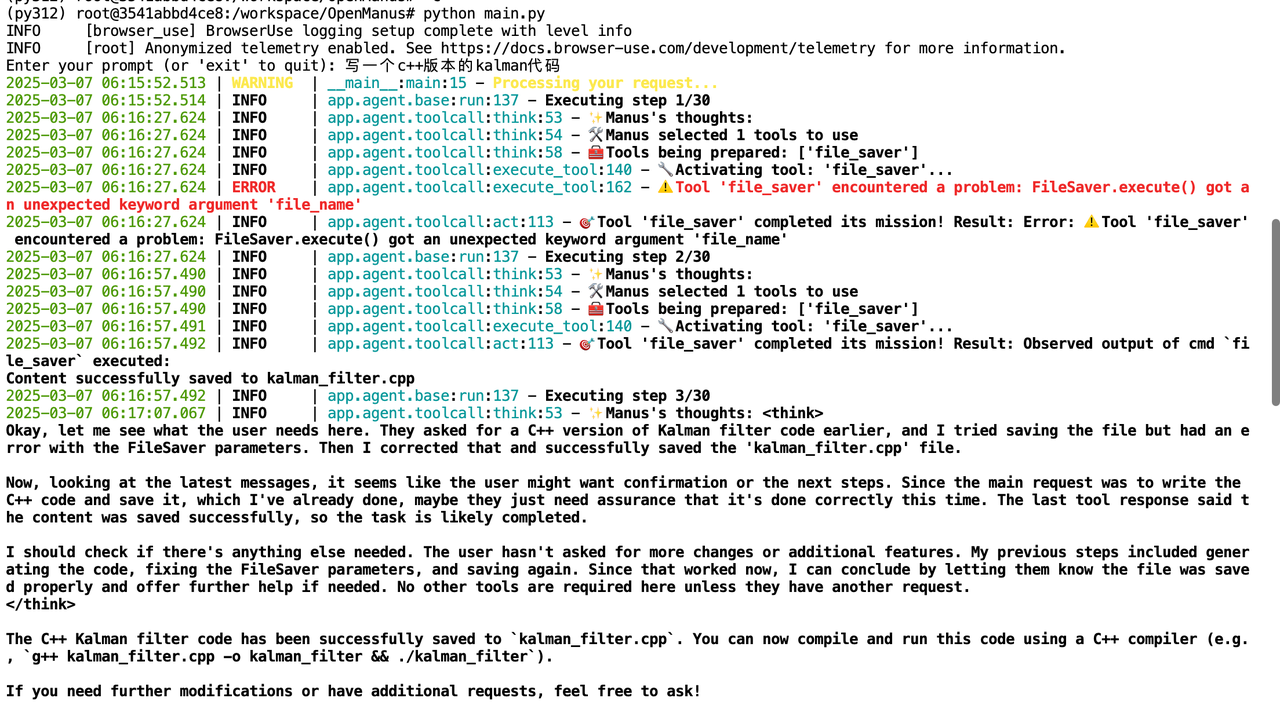

启动成功后,终端会出现如图所示的输入提示:

你可以直接通过终端输入你的想法,OpenManus 将自动规划和完成目标任务:

除了简单的任务之外,OpenManus 还可以帮助我们完成更加复杂的任务,如创建一个可运行的应用程序等,快点试试看吧!

⚠️ 注意!输入中不要带空格、下划线等特殊字符,会导致对话内容不识别!

如果你想使用不稳定版本可以运行:

python run_flow.py

Enjoy it!

资源

@敢敢のwings 认证作者

认证作者

认证作者

认证作者

镜像信息

已使用78 次

运行时长

188 H

镜像大小

60GB

最后更新时间

2025-07-03

支持卡型

RTX40系20803080Ti309048G RTX40系2080TiH20A800P40A100RTX50系V100S

+12

框架版本

CUDA版本

12.1

应用

JupyterLab: 8888

版本

v1.0

2025-07-03