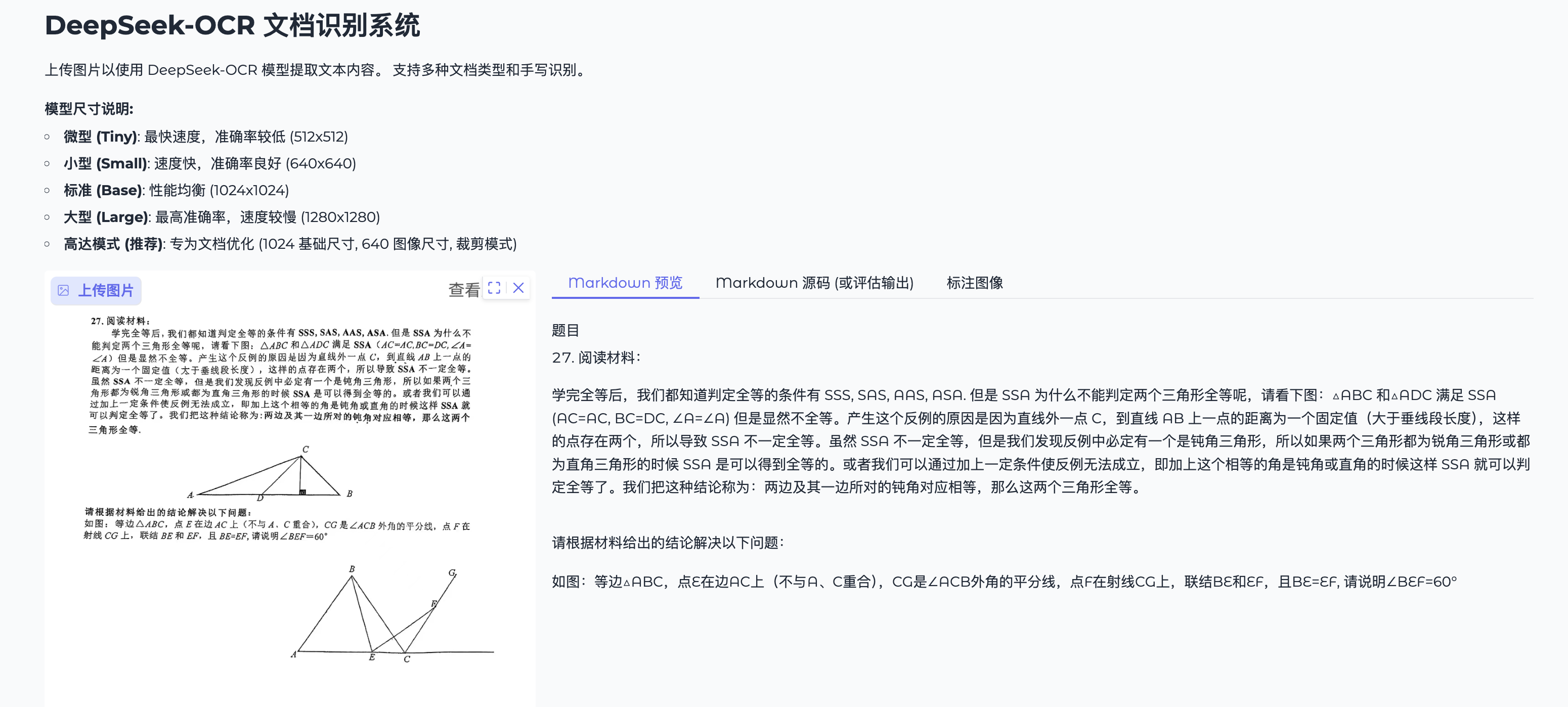

DeepSeek-OCR webui汉化vllm加速优化推理多种推理模式 构建by科哥

webui汉化vllm加速优化推理多种推理模式

0

00元/小时

v1.1

设计理念:

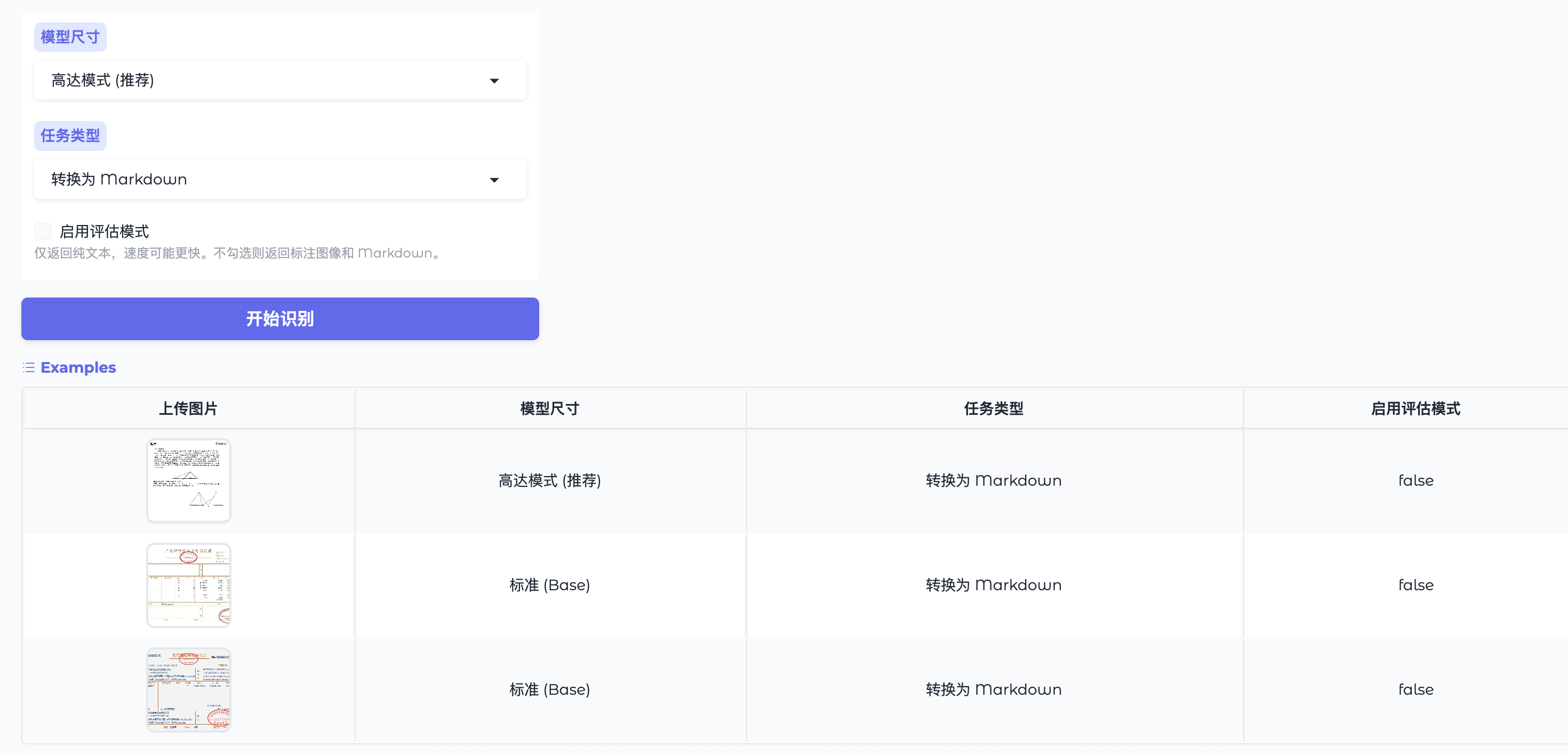

base_size: 模型内部处理的基础分辨率image_size: 实际输入图像的目标尺寸crop_mode: 对长文档进行智能分块处理,平衡质量与性能- Gundam 模式: 以较小的图像尺寸 + crop 模式,实现文档识别的最佳性价比

3. GPU 资源管理

@spaces.GPU # ZeroGPU 装饰器:按需分配 GPU,推理完成后自动释放

def process_image(image, model_size, task_type, is_eval_mode):

model_gpu = model.cuda().to(torch.bfloat16) # 动态移至 GPU + bfloat16 优化

# ... 推理逻辑 ...

# 函数结束后,GPU 自动释放

关键洞察: 模型在启动时加载到 CPU,仅在推理时移至 GPU。这是 ZeroGPU 环境的最佳实践。

4. 输出格式设计

应用返回三种格式,满足不同用户需求:

-

带标注图像 (

result_with_boxes.jpg):- 仅在

Convert to Markdown任务中生成 - 展示检测到的文本区域边界框

- 仅在

-

Markdown 内容 (

result.mmd):- 保留文档结构(标题、列表、表格等)

- 适合直接集成到文档工作流

-

纯文本结果:

- 模型直接返回的原始文本

- 适合复制粘贴或进一步处理

本地部署指南 (重要更新 2025-11-08)

快速启动

# 使用启动脚本 (推荐)

./start_app.sh

# 手动启动

conda activate py312

python app.py

访问地址: http://127.0.0.1:7860

环境要求

- Python: 3.12.0 (conda 环境:

py312) - 模型位置:

./models/DeepSeek-OCR/(6.3GB,完全本地化) - GPU: 可选,支持 CUDA (CPU 也可运行)

- 核心依赖: gradio, transformers==4.46.3, torch==2.6.0

bug反馈可以加入科哥专属群交流➕ 广告勿进!

优云镜像使用操作一般流程:

1、在社区镜像区域,选择镜像:

2、在打开的新页面 点击“使用该镜像创建实例”:

3、选择一个合适的显卡【GPU】根据情况选择:

4、确认部署信息无误,点击“开始部署”,然后等待部署完成:

如何启动应用

不是自动运行的应用:

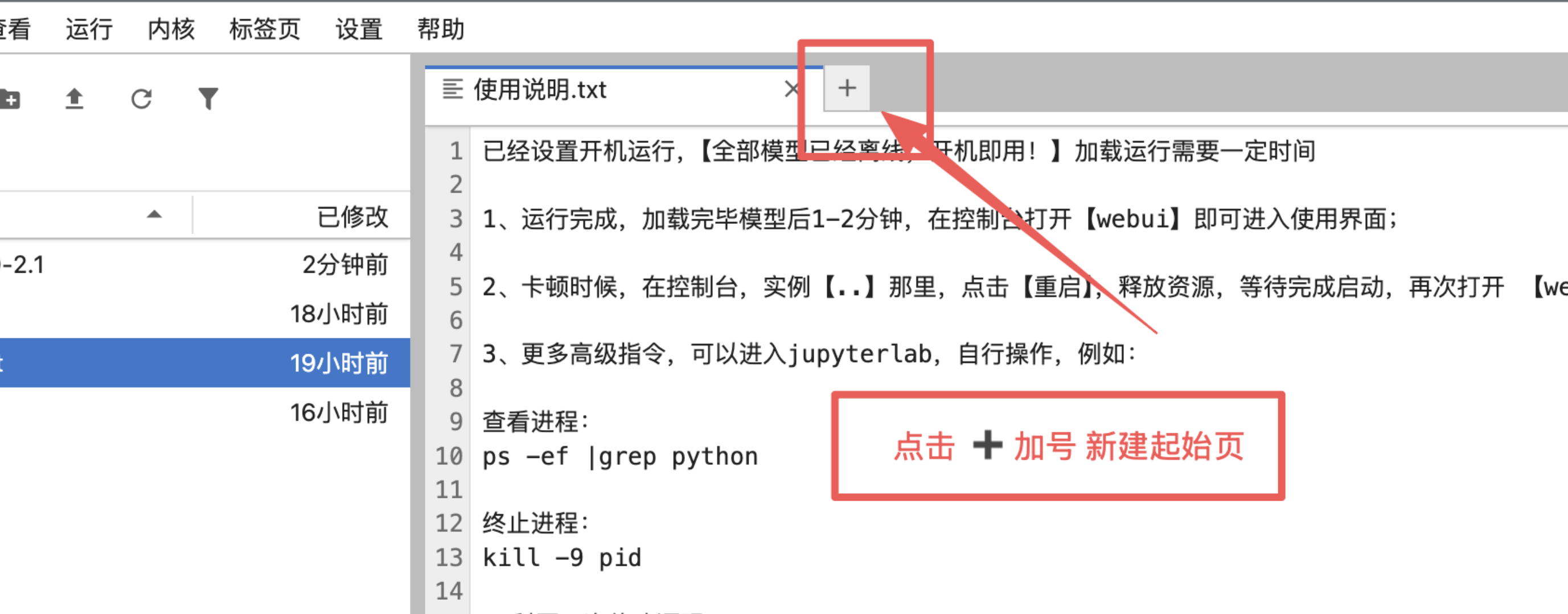

1、手动点击加号新建起始页:

2、打开终端:

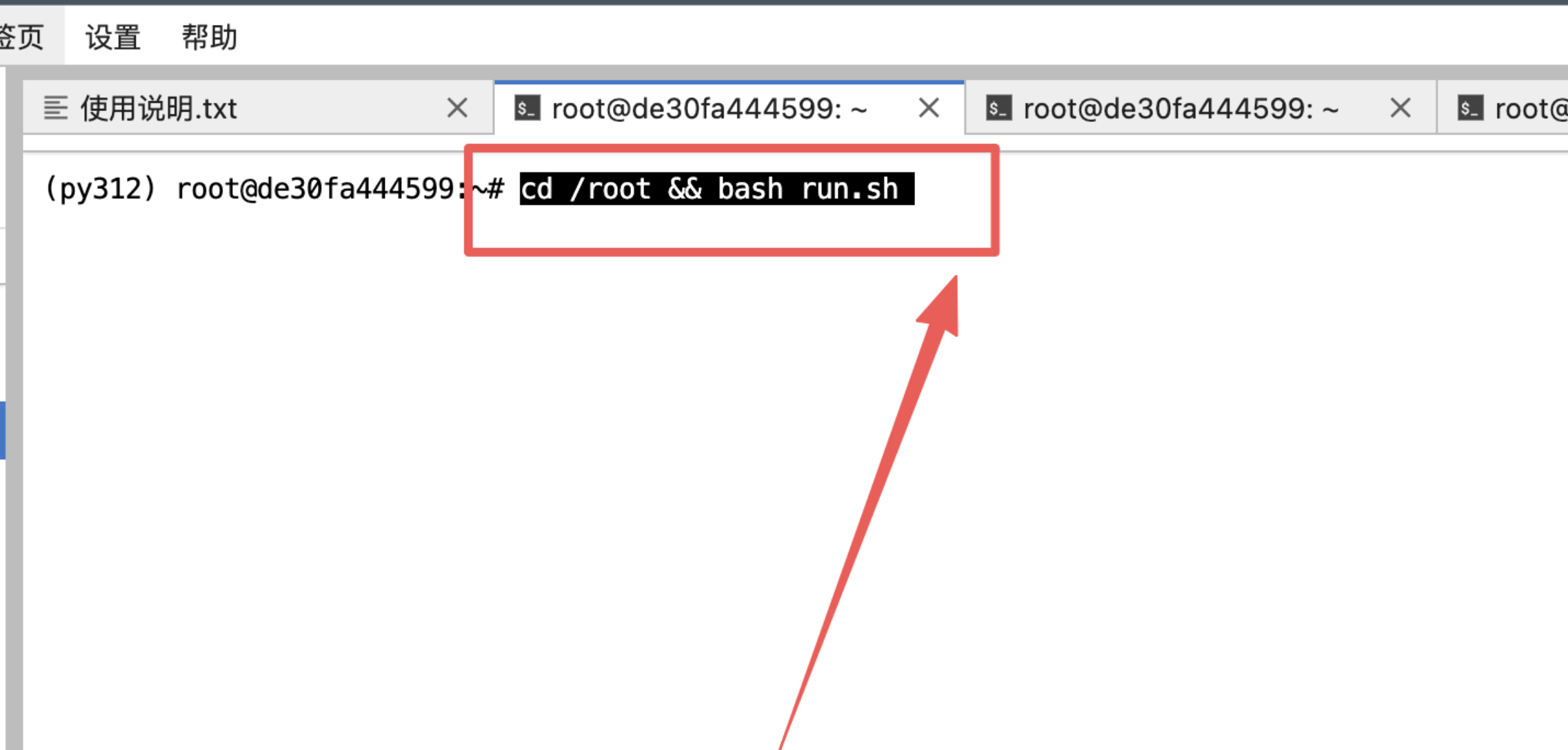

3、输入指令然后回车:

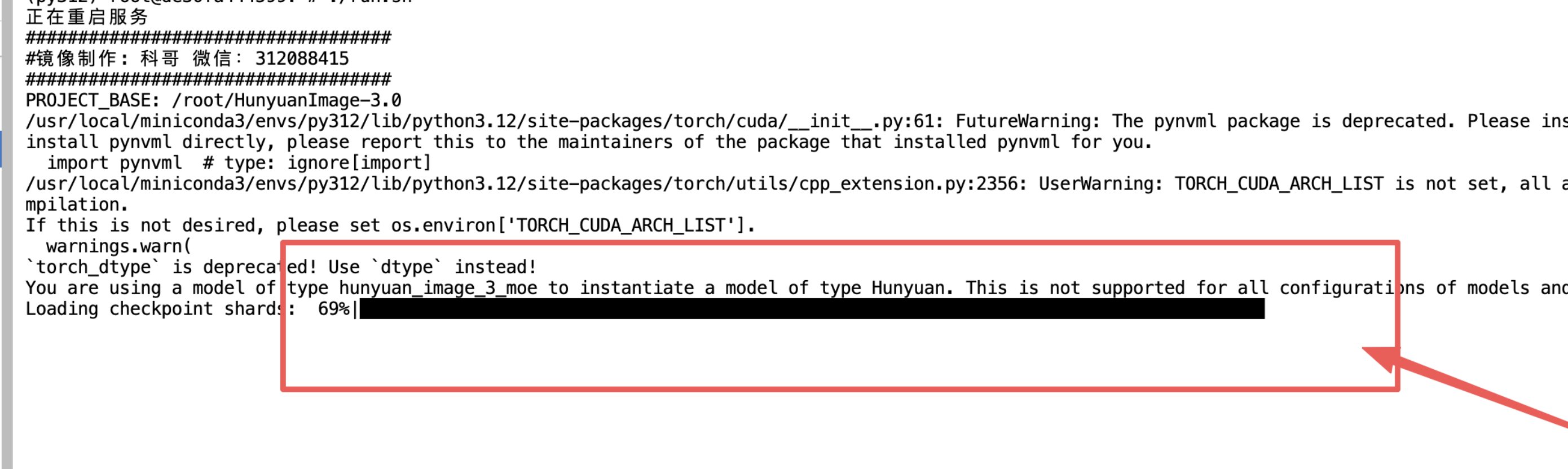

4、等待加载模型完毕:

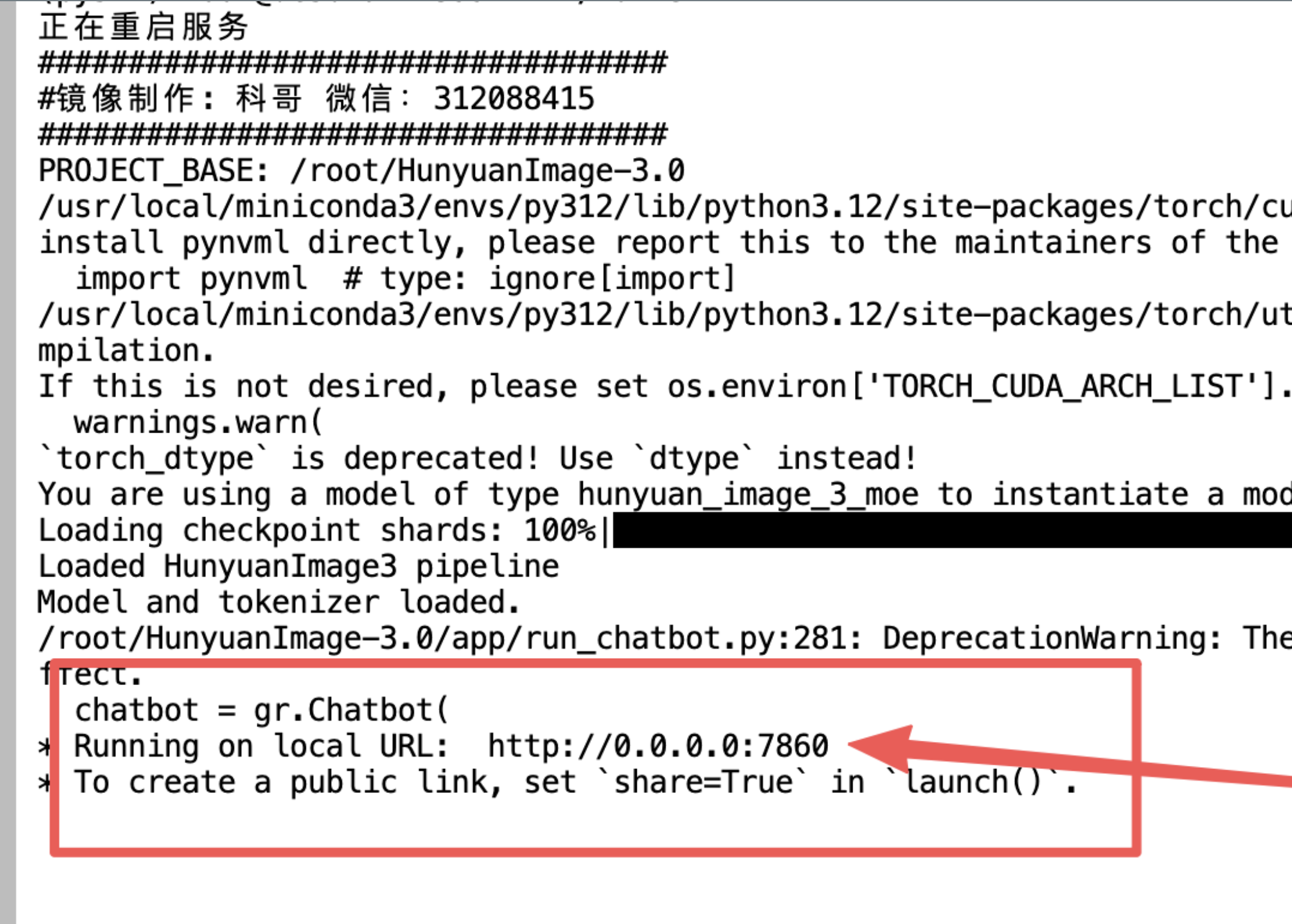

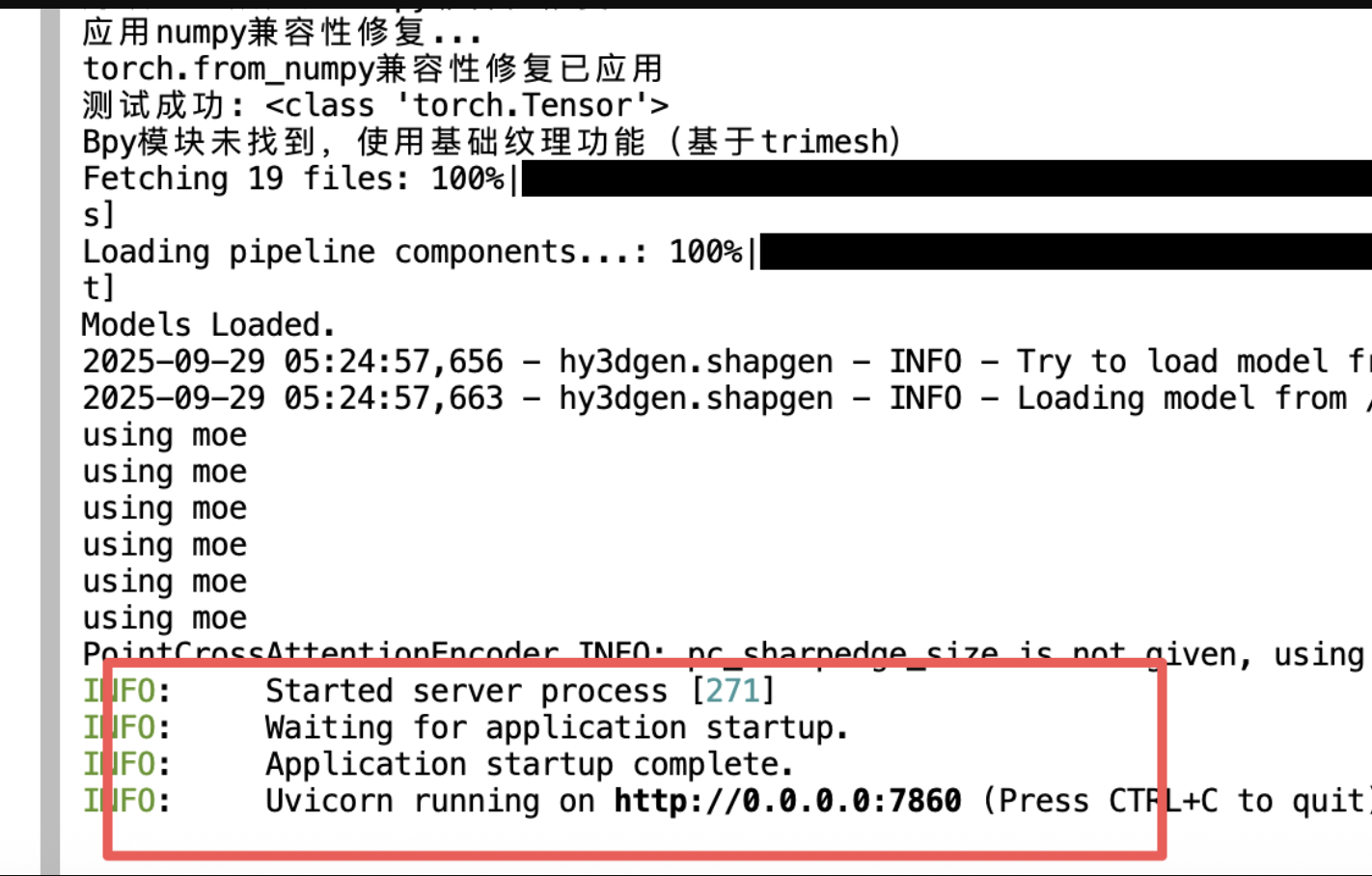

5、看到这个出现:

6、返回控制面板打开“SD-WebUI”

- AI数字人直播卖货欢迎来了解: https://kege-aigc.feishu.cn/docx/G271dgZr1o8CvMx9KKrcRuuonDf

以上都是镜像运行打开操作的一般步骤

优其他使用报错问题加群咨询

更多高级指令,可以进入jupyterlab,自行操作,例如:

- 查看进程:

ps -ef |grep python

- 终止进程:

kill -9 pid

- 重启程序:

cd /root && bash run.sh

- 官方更新源码在这里:

- https://github.com/deepseek-ai/DeepSeek-OCR

有bug请微信科哥或加群: 312088415

科哥在UCloud镜像列表【不断更新中】:

镜像信息

@科哥AIGC

认证作者

认证作者已使用1 次

运行时长

0 H

镜像大小

50GB

最后更新时间

2025-11-09

支持卡型

3090RTX50系RTX40系48G RTX40系2080Ti3080Ti2080H20P40A100A800

+11

框架版本

CUDA版本

12.8

应用

JupyterLab: 8888

版本

v1.1

2025-11-09