LiveTalking

LiveTalking镜像提供实时交互数字人解决方案,支持ERNerf、MuseTalk、Wav2Lip,实现单张人脸照片驱动的超低延迟(<100ms)唇形同步、表情及头部运动控制。

75

750元/小时

v1.6

最新

v1.5

v1.4

v1.3

v1.2

v1.1

LiveTalking数字人镜像

镜像简介

本镜像提供名为LiveTalking的实时交互式数字人解决方案,支持ERNerf、MuseTalk、wav2lip、ultralight-digitalhuman等多种前沿技术,能够实现流畅的流式音视频对话与驱动。适用于虚拟直播、在线客服、远程互动演示及实时内容创作等场景,为用户提供免费、高效且高度拟真的实时数字人生成与交互体验。

镜像使用指南

一、快速使用

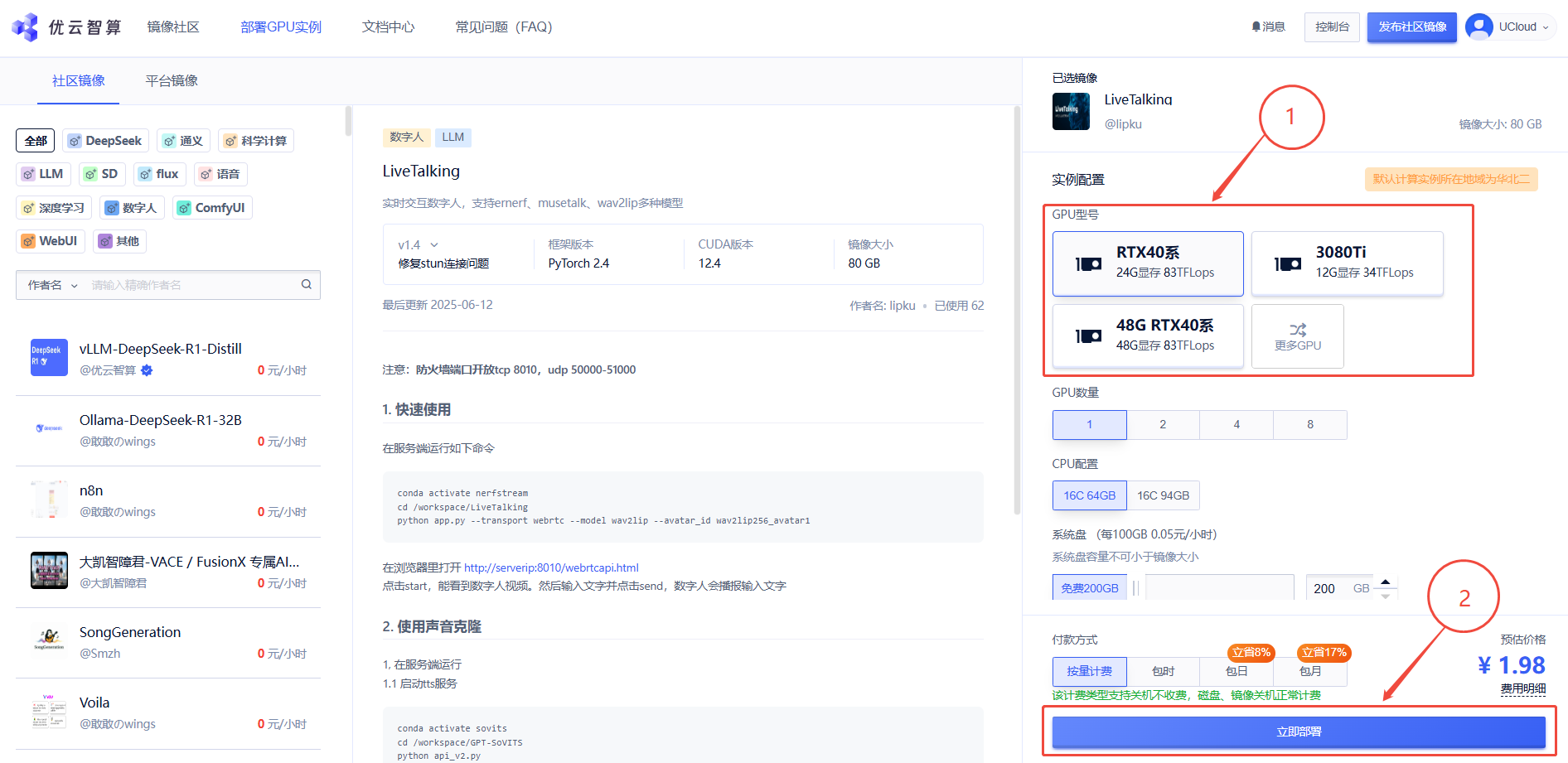

1. 先选择GPU型号,再点击“立即部署”

2. 待实例初始化完成后,在控制台-应用中打开“JupyterLab”

3. 进入JupyterLab后,新建一个终端Terminal,在Terminal中运行如下命令

conda activate nerfstream

cd /workspace/LiveTalking

python app.py --transport webrtc --model wav2lip --avatar_id wav2lip256_avatar1

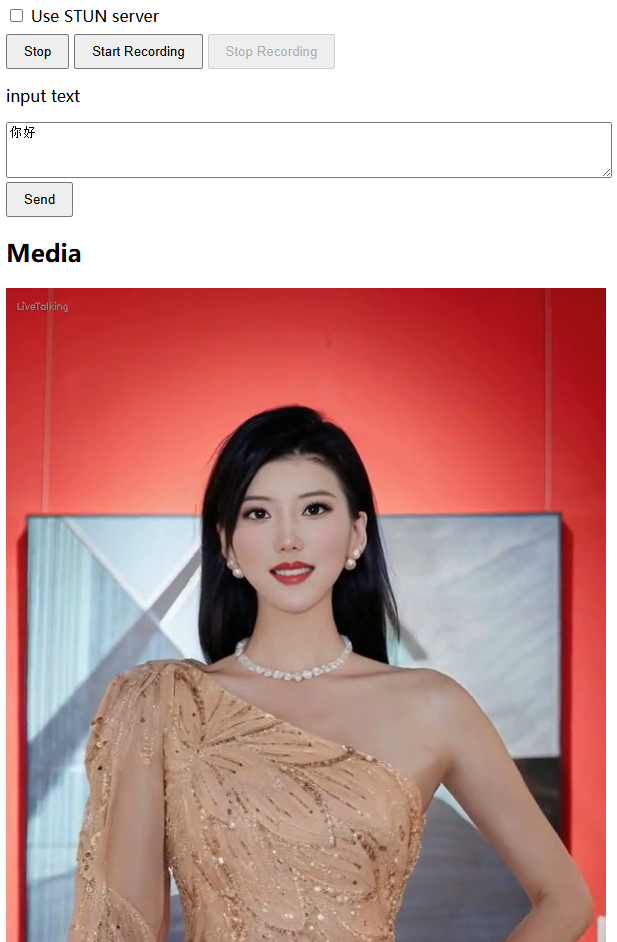

当出现以下运行结果时,即可在浏览器里打开 http://serverip:8010/webrtcapi.html

serverip可以在控制台-基础网络(外)复制得到

进入web界面后点击start,能看到数字人视频。然后输入文字并点击send,数字人会播报输入文字

二、使用声音克隆

1. 如启动方法一,进入JupyterLab后,新建一个终端Terminal,在终端中输入以下指令启动tts服务

conda activate sovits

cd /workspace/GPT-SoVITS

python api_v2.py

2. 不要关闭前一个正在运行的终端,再新建一个终端,输入以下指令启动数字人服务

conda activate nerfstream

cd /workspace/LiveTalking

然后根据不同数字人模型运行(只需选择一个运行即可)

-

museltalk:

python app.py --model musetalk --transport webrtc --avatar_id musetalk_avatar1 --tts gpt-sovits --TTS_SERVER http://127.0.0.1:9880 --REF_FILE ~/zero_shot_prompt.wav --REF_TEXT 希望你以后能够做的比我还好呦 -

wav2lip:

python app.py --transport webrtc --model wav2lip --avatar_id wav2lip256_avatar1 --tts gpt-sovits --TTS_SERVER http://127.0.0.1:9880 --REF_FILE ~/zero_shot_prompt.wav --REF_TEXT 希望你以后能够做的比我还好呦

3. 最后在浏览器里打开 http://serverip:8010/webrtcapi.html ,点击start,能看到数字人视频。然后输入文字并点击send,数字人会播报输入文字

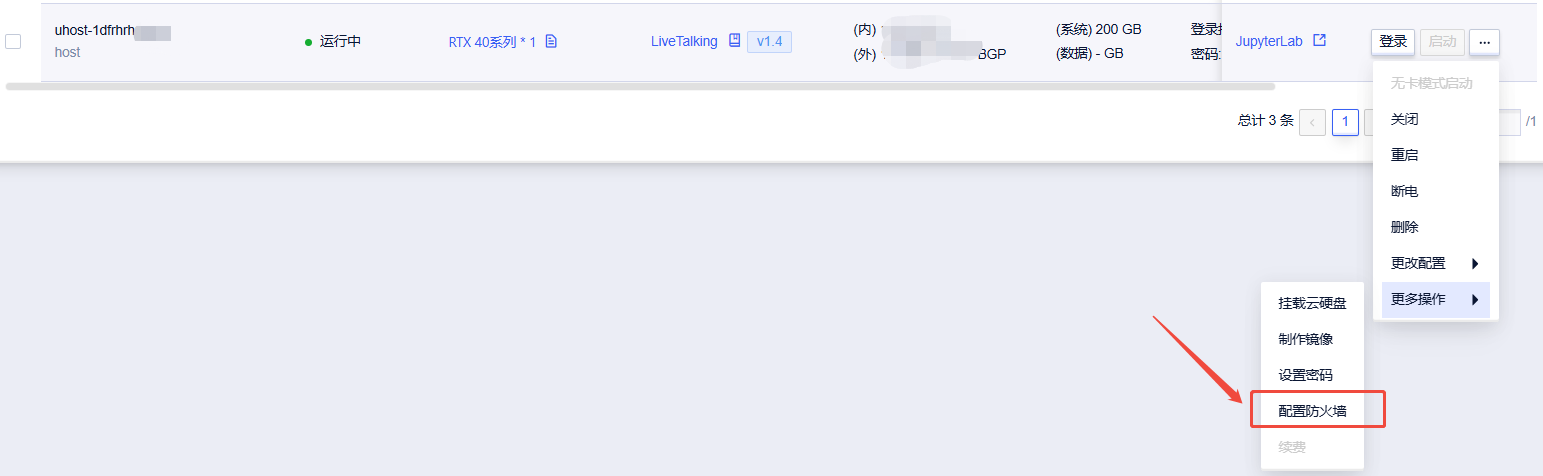

三、防火墙设置教程

使用该镜像时可能出现数字人无法显示的问题,此时需检查防火墙设置是否正确,防火墙端口需开放tcp 8010,udp 50000-51000

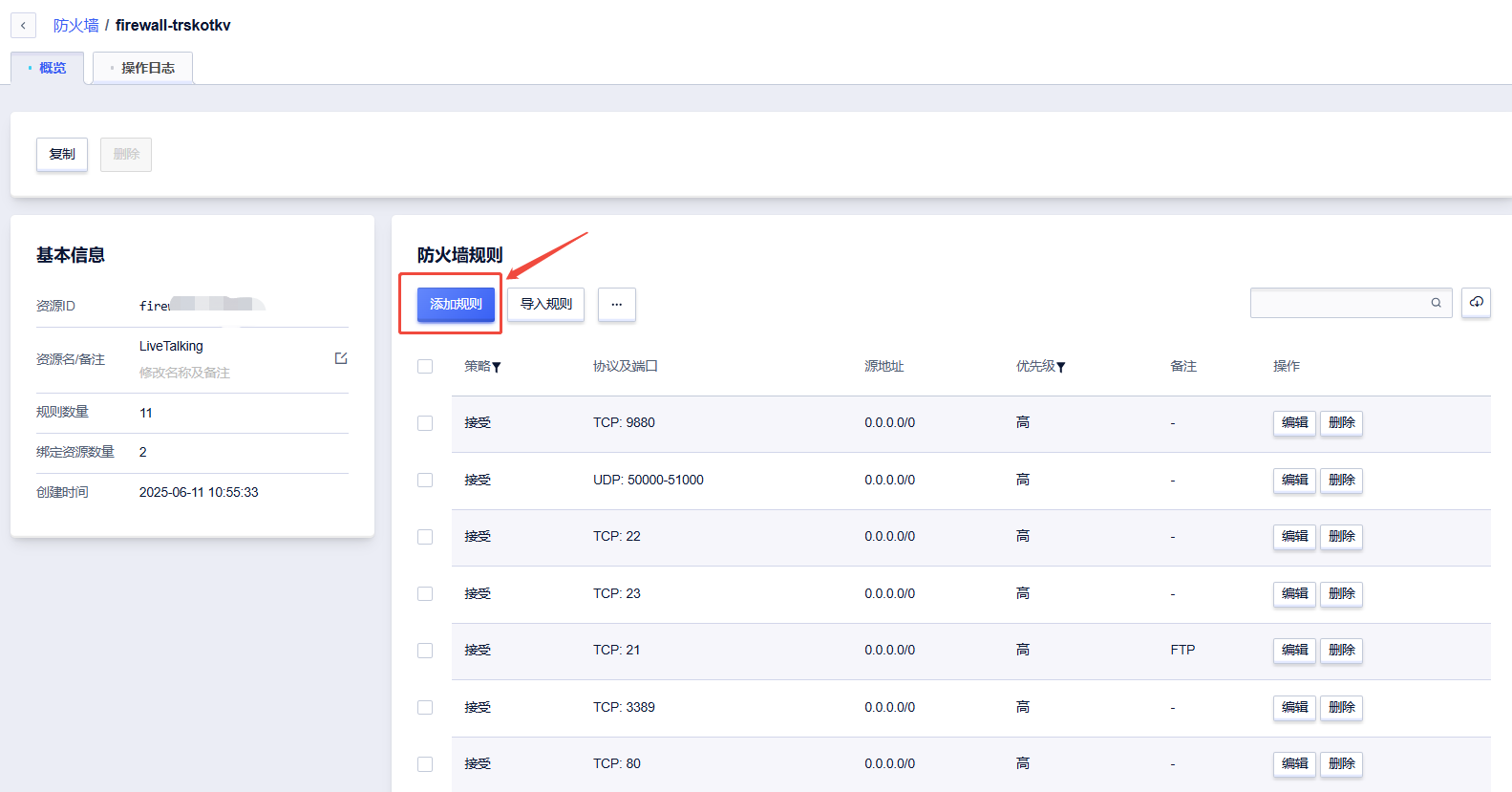

1. 如图所示,在控制台-操作中打开配置防火墙

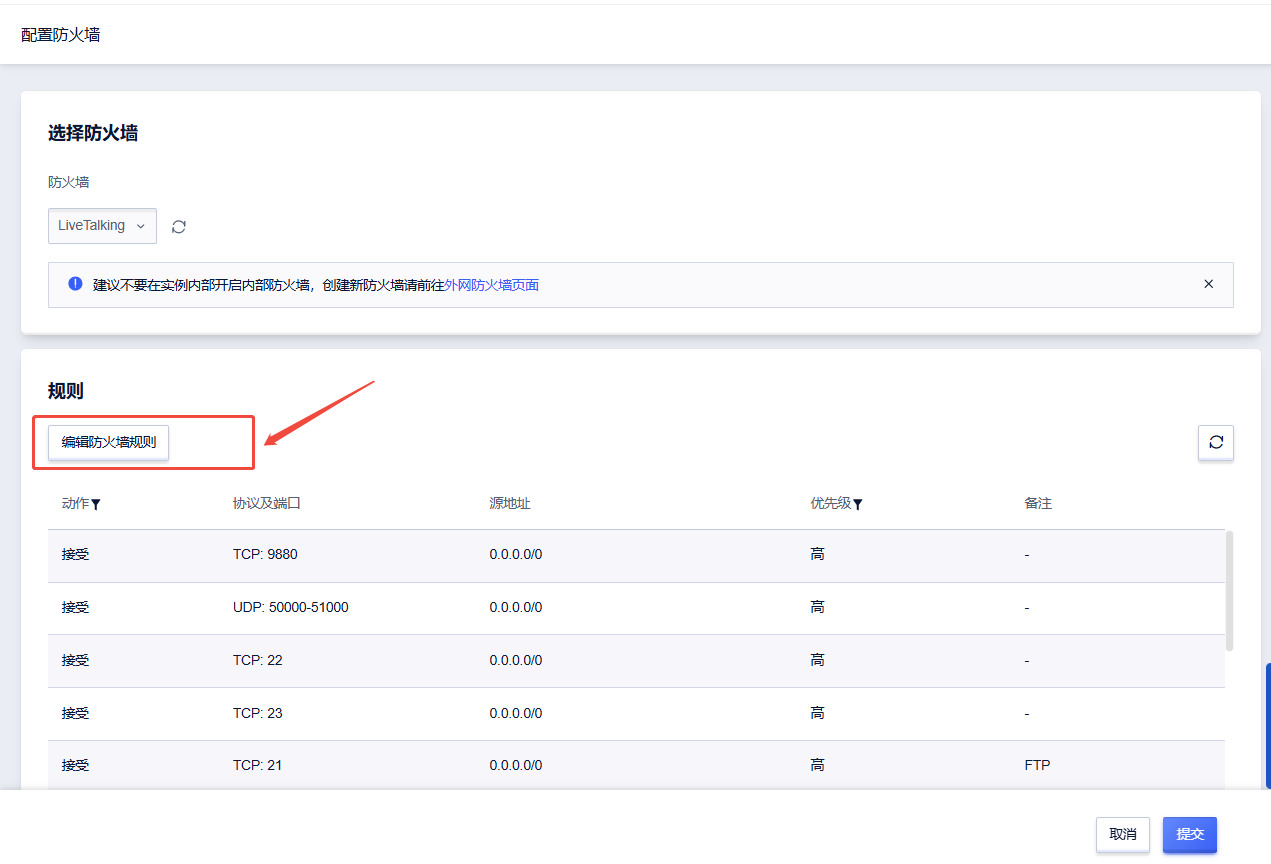

2. 点击“编辑防火墙规则”

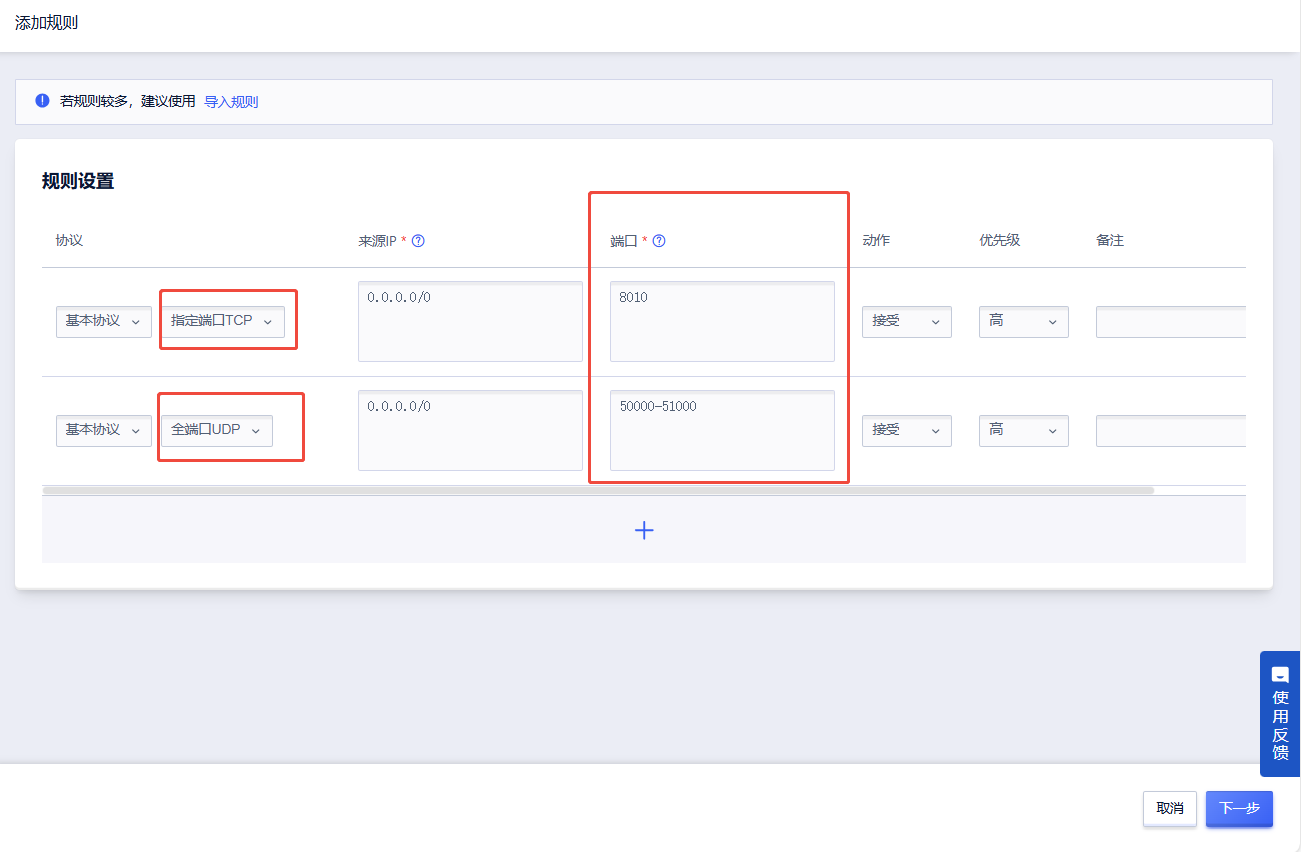

3. 点击“添加规则”

4. 选择指定端口TCP,输入端口号8010;选择全端口UDP,输入端口号50000-51000;再点击下一步

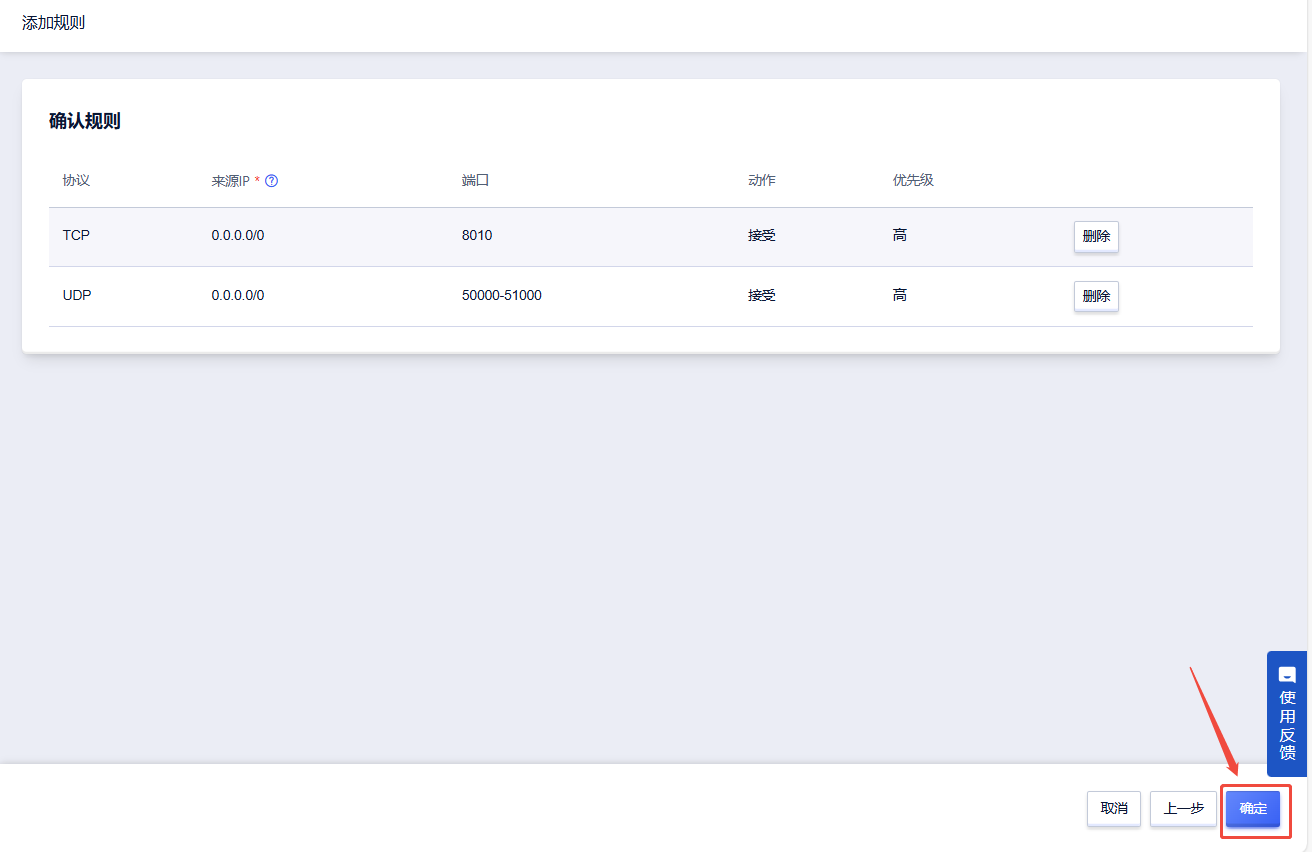

5. 检查端口号,点击“确认”后即添加成功,可以回到防火墙规则中确认是否添加

@lipku 认证作者

认证作者

认证作者

认证作者

镜像信息

已使用43 次

运行时长

68 H

推荐

推荐镜像大小

60GB

最后更新时间

2026-02-27

支持卡型

3080TiRTX40系RTX50系309048G RTX40系2080TiA800H20P40A100

+10

框架版本

CUDA版本

12.4

应用

JupyterLab: 8888

自定义开放端口

8010

+1

版本

v1.6

2026-02-27

v1.5

2026-02-03

v1.4

2026-02-03

查看全部