thinking-budget-vllm010

使用vllm实现思考预算

2

20元/小时

v1.0

S1: Thinking Budget with vLLM

镜像简介

本镜像基于vLLM高性能推理框架,实现“思考预算”机制,优化大语言模型的推理资源分配与思考深度控制。适用于智能决策、复杂问题分解、链式推理及资源优化分析等对推理效率与可控性有高要求的场景,为开发者提供高效、稳定且可定制化的大模型推理部署环境。

说明

首先,我们来了解一下AI教母李飞飞教授关于 Test-time scaling 的论文:《s1: Simple test-time scaling》

论文大致讲了个什么事情呢?简单来说,提出了一种新的测试时间缩放方法,旨在提高模型在推理阶段的效率和准确性。通过调整模型的思考预算,可以在不同的任务和数据集上实现更好的性能。

就是说对于一些复杂问题,需要用推理链来解决的问题,我们可以通过调整模型的思考预算来提高推理效率和准确性。上图也可以看到当思考预算增加时,模型的性能会有明显提升。

插一句题外话,论文中判断问题难易程度的方式是通过让 Qwen2.5-32B-Instruct 模型回答问题,答对的问题就是简单问题,答错的就是复杂问题。

论文也做了消融实验来探讨,在未满足思考预算时插入一些不同的特定词(如:Wait!)对模型最终性能的影响。结果表明,插入特定词可以有效地引导模型进行更深入的思考,并且“Wait,Wait”的效果最好。

镜像使用指南

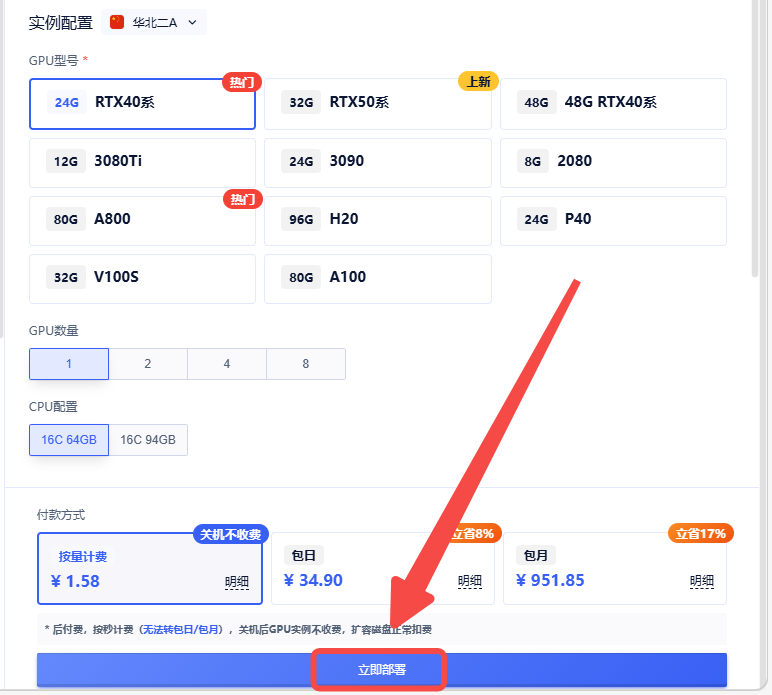

1.创建实例

2.选择合适的机型,立即部署

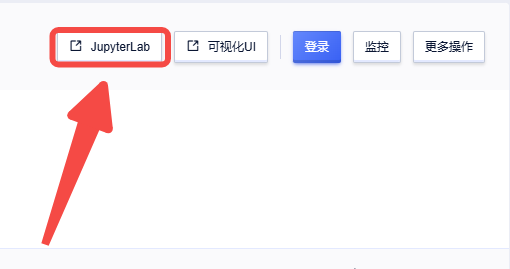

3.启动成功后,点击【JupyterLab】进行操作

3.启动成功后,点击【JupyterLab】进行操作

@不要葱姜蒜 认证作者

认证作者

认证作者

认证作者

镜像信息

已使用3 次

运行时长

0 H

镜像大小

60GB

最后更新时间

2026-02-02

支持卡型

RTX40系20803080Ti309048G RTX40系2080TiH20A800P40A100RTX50系V100SV100S

+13

框架版本

CUDA版本

12.4

应用

JupyterLab: 8888

版本

v1.0

2026-02-02