Qwen3-Smvl多模态模型

最近Huggingface团队发布了超小多模态模型SmolVLM2,可以做到端侧1GB显存推理。作者尝试当前中文小模型扛把子Qwen3与SmolVLM2直接微调拼接的想法

1

10元/小时

v1.0

Qwen3-Smvl多模态模型

镜像简介

本教程将介绍一种模型拼接的思路,将SmolVLM2的视觉模块(0.09B)与Qwen3最小的模型(0.6B)进行对齐微调,最终使得Qwen模型具备一定的视觉理解能力。由于笔者时间有限且考虑到文章篇幅的原因,因此该系列预计将以系列的方式放出。篇幅规划如下:

第一篇:如何构建和微调一个拼接模型(本篇博客) 第二篇:模型测评、数据集优化、回答人类对齐 第三篇:微调技巧介绍、视觉位置编码改动与模型结构优化

镜像使用方法

1.创建实例

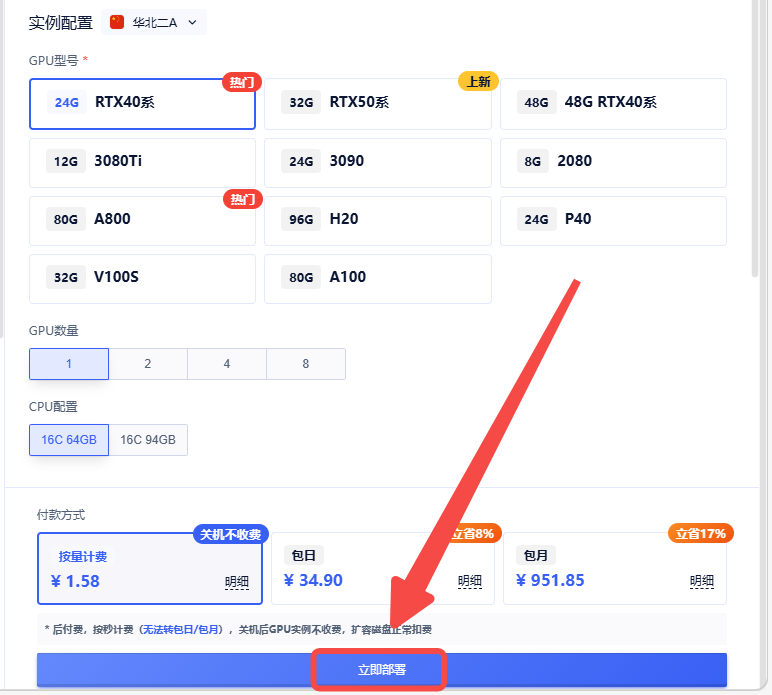

2.选择合适的机型,立即部署

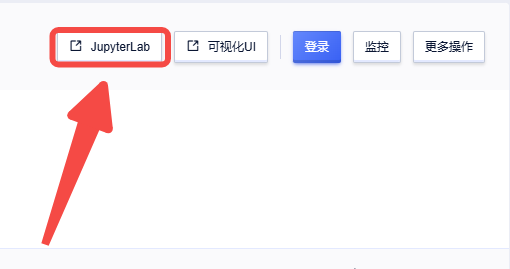

3.启动成功后,点击【JupyterLab】,进入terminal

3.启动成功后,点击【JupyterLab】,进入terminal

小批量微调训练

为了进行快速验证,笔者首先使用cocoqa数据集并且进行了200steps的训练,所有参数与前文所述一致。通过 运行实验命令如下,推荐使用8卡进行训练,在8张沐曦GPU卡上预计需要使用20min

# 单GPU训练

CUDA_VISIBLE_DEVICES=0 python train.py ./cocoqa_train.yaml

# 8GPU训练

accelerate launch --num_process 8 train.py ./cocoqa_train.yaml

#全量微调

CUDA_VISIBLE_DEVICES=0 python train_staged.py ./staged_training.yaml

@敢敢のwings 认证作者

认证作者

认证作者

认证作者

镜像信息

已使用3 次

运行时长

0 H

支持自启动

支持自启动镜像大小

140GB

最后更新时间

2026-02-02

支持卡型

RTX40系20803080Ti309048G RTX40系2080TiH20A800P40A100RTX50系V100S

+12

框架版本

CUDA版本

12.4

应用

JupyterLab: 8888

版本

v1.0

2026-02-02