Ollama-WebUI

Ollama是一个开源的大型语言模型服务工具,它允许用户在自己的硬件环境中轻松部署和使用大规模预训练模型。Ollama 的主要功能是在Docker容器内部署和管理大型语言模型(LLM),使得用户能够快速地在本地运行这些模型。它简化了部署过程,通过简单的安装指令,用户可以执行一条命令就在本地运行开源大型语言模型,例如Llama 3。

0

00元/小时

v1.0

Ollama项目介绍

Ollama是一个开源的大型语言模型服务工具,它允许用户在自己的硬件环境中轻松部署和使用大规模预训练模型。Ollama 的主要功能是在Docker容器内部署和管理大型语言模型(LLM),使得用户能够快速地在本地运行这些模型。它简化了部署过程,通过简单的安装指令,用户可以执行一条命令就在本地运行开源大型语言模型,例如Llama 3。

项目特色

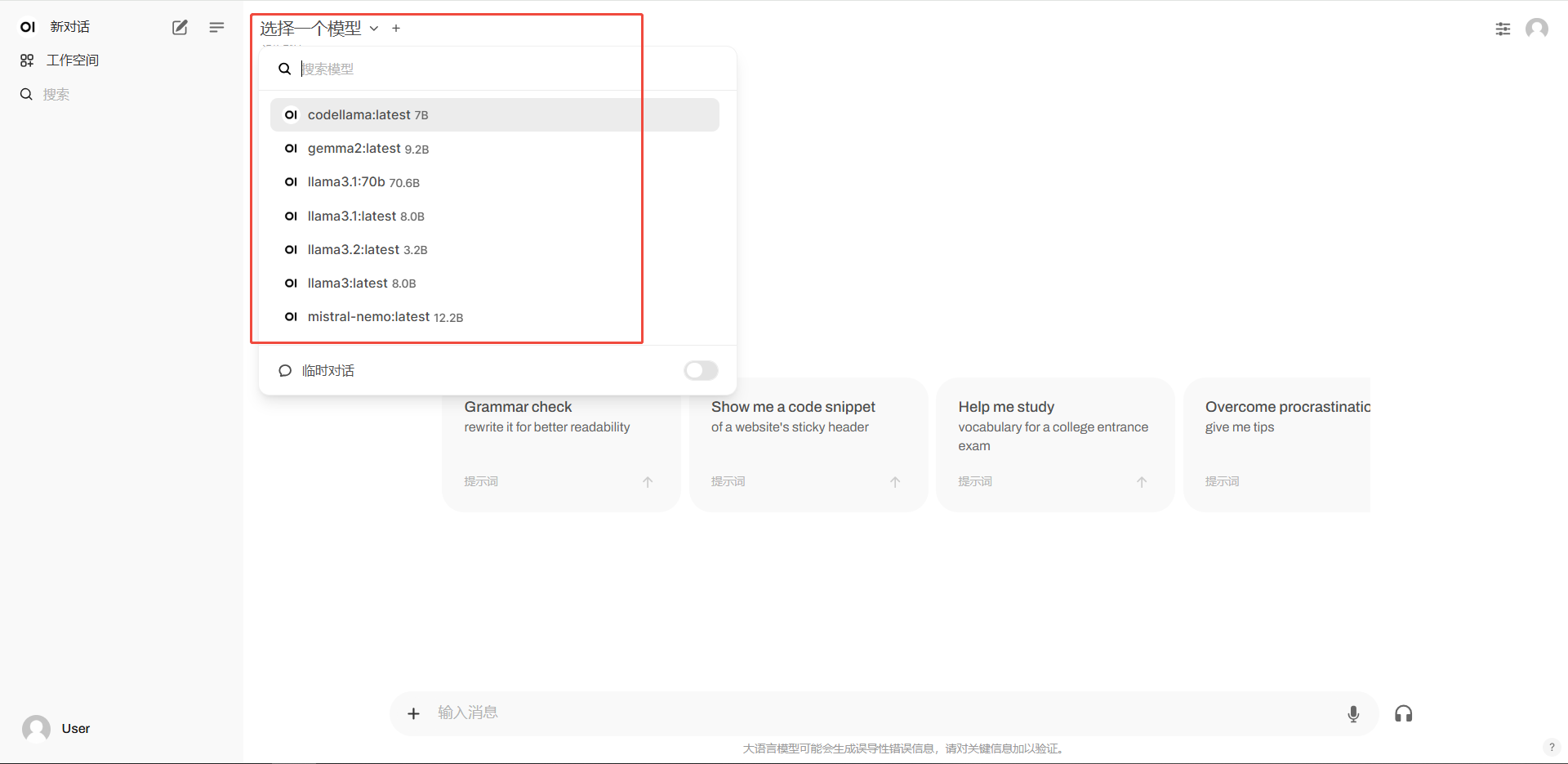

- 预装Open WebUI,能直接运行大模型,与大模型进行对话

- 多种模型支持,Llama、Mistral、Mixtral-MoE、Qwen、Qwen2.5

- Ollama 命令具有管理大模型的能力

- 本地大模型安全可靠

- 终端直接开始聊天

使用方式

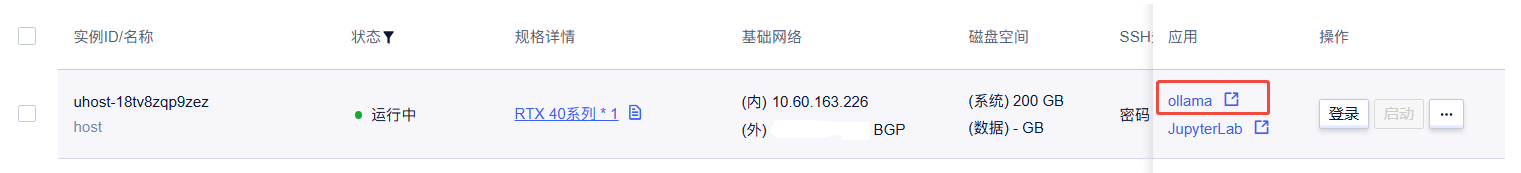

浏览器访问:外网ip:8080,或直接从资源列表打开

webui界面

webui界面

@优云智算

镜像信息

已使用70 次

运行时长

96 H

镜像大小

40GB

最后更新时间

2025-07-11

支持卡型

RTX40系RTX50系

+2

框架版本

CUDA版本

12.1

应用

ollama: 8080

版本

v1.0

2025-07-11