Qwen

Qwen镜像集成通义千问开源大语言模型系列

0

00元/小时

v1.0

Qwen-7B、Qwen-VL使用手册

镜像简介

Qwen镜像集成通义千问开源大语言模型系列,提供Qwen-7B基础对话模型与Qwen-VL多模态模型,支持中英双语128K长上下文、代码生成及图像理解,基于高质量预训练与对齐优化实现强任务泛化能力,兼顾高性能与开源友好部署特性。

1. 环境准备

1.1 创建 Jupyter 实例并打开终端

在成功创建 Jupyter 实例后,进入终端界面,执行以下命令以克隆 Qwen 仓库:

git clone https://github.com/QwenLM/Qwen

1.2 安装依赖

进入 Qwen 目录并安装所需依赖:

cd Qwen

pip install -r requirements.txt

1.3 安装 ModelScope

安装 ModelScope 库:

pip install modelscope

2. 模型下载

2.1 创建下载脚本

使用文本编辑器(如 vim)创建并编辑下载脚本 don.py:

vim don.py

在 don.py 中添加以下代码以下载 Qwen 模型:

from modelscope import snapshot_download

# 下载 Qwen-7B-Chat 模型

model_dir = snapshot_download(qwen/Qwen-7B-Chat, cache_dir=./model, revision=master)

# 下载 Qwen-VL-Chat 模型

model_dir = snapshot_download(Qwen/Qwen-VL-Chat, cache_dir=./model, revision=master)

2.2 运行下载脚本

在命令行中输入以下命令以执行下载脚本:

python don.py

3. 启动 Demo 脚本

3.1 启动对话 Demo

在 Qwen 目录下的终端中运行以下命令启动对话 Demo:

python cli_demo.py

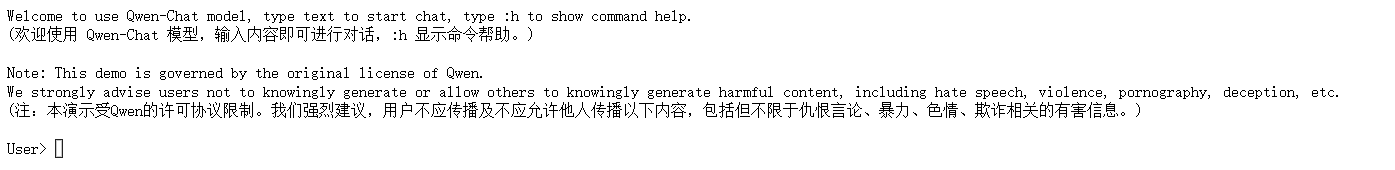

成功开启对话后,您将看到如下界面:

3.2 启动 VL 模型

如果希望运行视觉语言(VL)模型,可以执行以下命令:

python VL_qwen.py

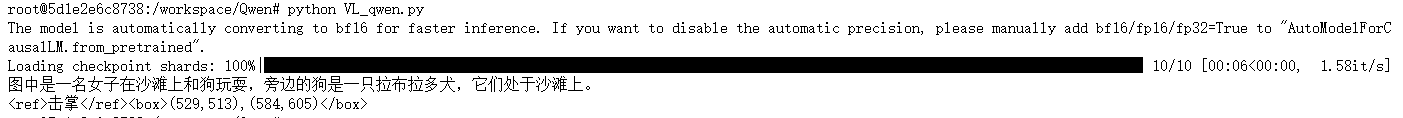

运行后,您将看到如下界面:

@敢敢のwings 认证作者

认证作者

认证作者

认证作者

镜像信息

已使用17 次

运行时长

1 H

镜像大小

60GB

最后更新时间

2026-02-04

支持卡型

RTX40系20803080Ti309048G RTX40系2080TiH20A800P40A100RTX50系V100SV100S

+13

框架版本

CUDA版本

12.4

应用

JupyterLab: 8888

版本

v1.0

2026-02-04