InternLM2-7B-chat

InternLM2-7B-Chat镜像集成上海AI实验室开源对话大语言模型,通过7B参数架构与128K上下文窗口优化长程对话一致性,专注智能体任务与多轮交互,支持低成本本地部署及XTuner微调工具链,提供开箱即用对话服务

0

00元/小时

v1.0

InternLM2-7B-chat 部署

InternLM2 ,即书生·浦语大模型第二代,开源了面向实用场景的70亿参数基础模型与对话模型 (InternLM2-Chat-7B)。模型具有以下特点:

- 有效支持20万字超长上下文:模型在20万字长输入中几乎完美地实现长文“大海捞针”,而且在 LongBench 和 L-Eval 等长文任务中的表现也达到开源模型中的领先水平。 可以通过 LMDeploy 尝试20万字超长上下文推理。

- 综合性能全面提升:各能力维度相比上一代模型全面进步,在推理、数学、代码、对话体验、指令遵循和创意写作等方面的能力提升尤为显著,综合性能达到同量级开源模型的领先水平,在重点能力评测上 InternLM2-Chat-20B 能比肩甚至超越 ChatGPT (GPT-3.5)。

- 代码解释器与数据分析:在配合代码解释器(code-interpreter)的条件下,InternLM2-Chat-20B 在 GSM8K 和 MATH 上可以达到和 GPT-4 相仿的水平。基于在数理和工具方面强大的基础能力,InternLM2-Chat 提供了实用的数据分析能力。

- 工具调用能力整体升级:基于更强和更具有泛化性的指令理解、工具筛选与结果反思等能力,新版模型可以更可靠地支持复杂智能体的搭建,支持对工具进行有效的多轮调用,完成较复杂的任务。

镜像快速使用教程

1. 待实例初始化完成后,在控制台-应用中打开”JupyterLab“

2. 进入Jupyter后,新建一个终端Terminal,输入以下指令

# 进入源码目录

cd /InternLM2/compshare-tmp/InternLM/

streamlit run ./chat/web_demo.py --server.address 0.0.0.0 --server.port 11434

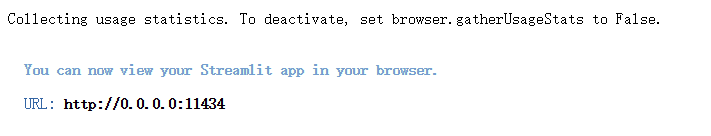

3. 运行出现如下结果时,即可在浏览器中访问 http://0.0.0.0:11434 ,其中0.0.0.0替换为外网ip,外网ip可以在控制台-基础网络(外)中获取

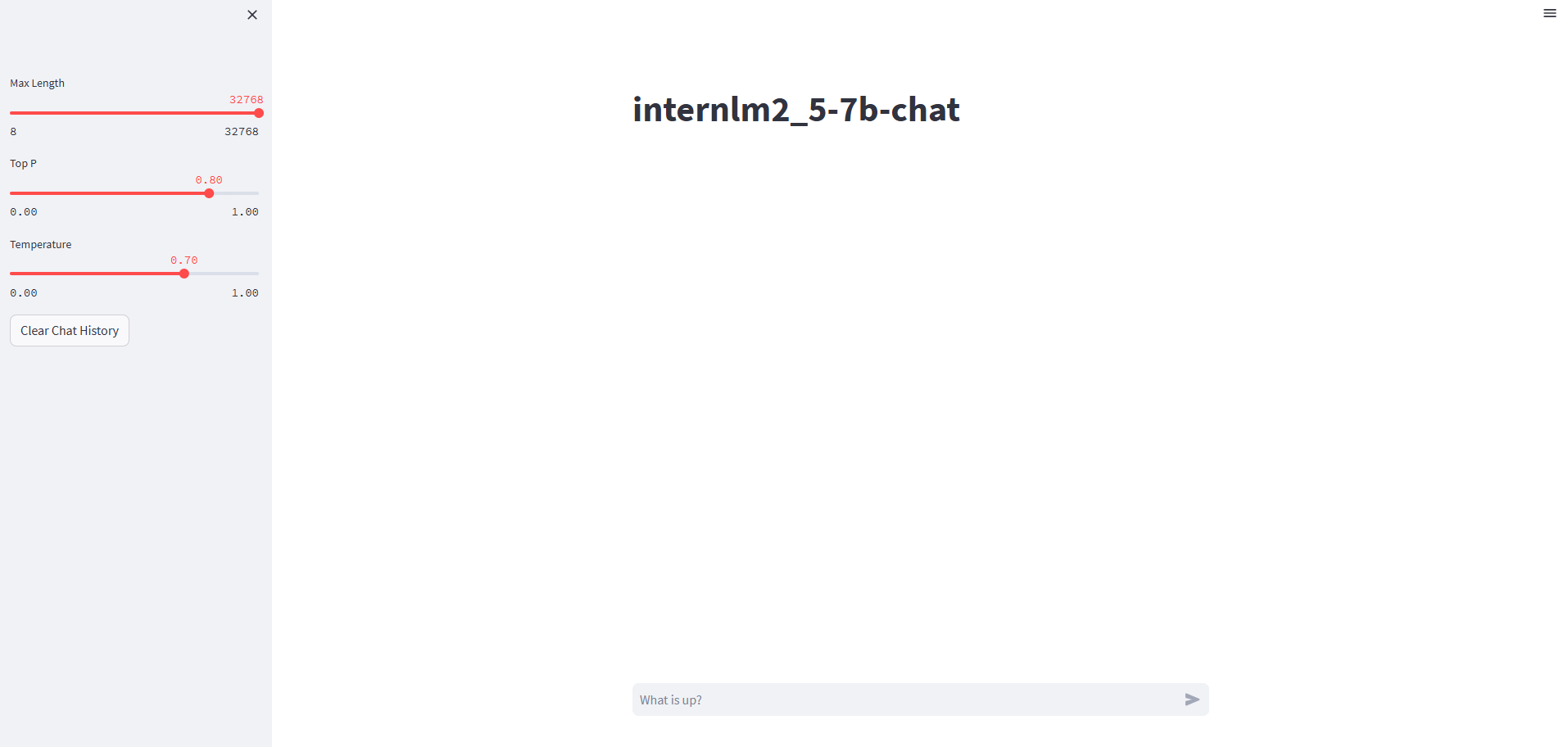

成功进入web界面如下图所示

环境安装

pip换源和安装依赖包,在ipynb文件里写入下面代码,点击运行

# 更换 pypi 源加速库的安装

pip config set global.index-url https://pypi.tuna.tsinghua.edu.cn/simple

# 安装python依赖

pip install modelscope==1.9.5

pip install transformers==4.36.2

pip install streamlit==1.24.0

pip install sentencepiece==0.1.99

pip install accelerate==0.24.1

pip install transformers_stream_generator==0.0.4

使用modelscope下载

使用 modelscope 中的 snapshot_download 函数下载模型,第一个参数为模型名称,参数 cache_dir 为模型的下载路径。运行下载internlm2-chat-7b模型。模型下载需要时间

from modelscope import snapshot_download

model_dir = snapshot_download(Shanghai_AI_Laboratory/internlm2-chat-7b, cache_dir=/InternLM2/compshare-tmp, revision=master)

代码准备

源码拉取

以下操作,可以在jupyter运行下载模型的过程中,你新开一个命令行终端进行操作

cd /InternLM2/compshare-tmp

# 下载 Internlm 代码

git clone https://github.com/InternLM/InternLM.git

安装依赖

# 进入源码目录

cd /InternLM2/compshare-tmp/InternLM/

# 安装internlm依赖

pip install -r requirements.txt

使用InternLM的web_demo运行

将 /InternLM2/compshare-tmp/InternLM/chat/web_demo.py中 183 行和 186 行的模型更换为本地的/InternLM2/compshare-tmp/Shanghai_AI_Laboratory/internlm2-chat-7b。

修改完成之后,启动web_demo.py文件

# 进入源码目录

cd /InternLM2/compshare-tmp/InternLM/

streamlit run ./chat/web_demo.py --server.address 0.0.0.0 --server.port 11434

在浏览器打开 http://(外部ip):11434 界面,模型加载,即可使用。

@敢敢のwings 认证作者

认证作者

认证作者

认证作者

镜像信息

已使用5 次

运行时长

0 H

镜像大小

50GB

最后更新时间

2025-07-14

支持卡型

RTX40系20803080Ti309048G RTX40系2080TiH20A800P40A100RTX50系V100SV100S

+13

框架版本

CUDA版本

12.4

应用

JupyterLab: 8888

版本

v1.0

2025-07-14