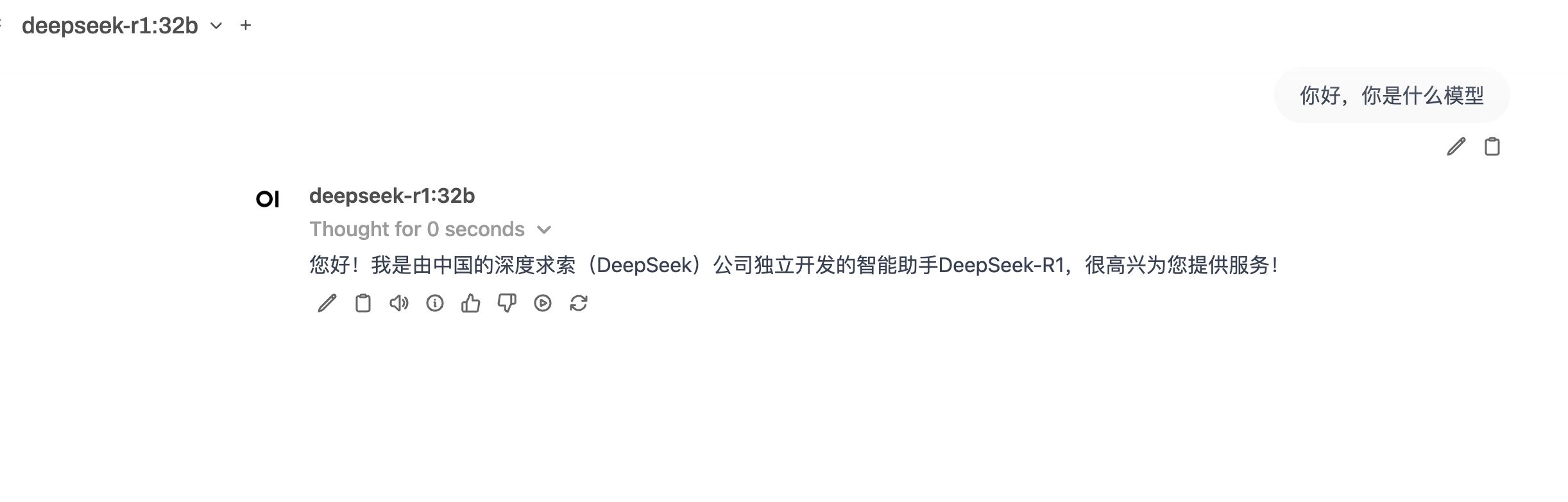

Ollama-DeepSeek-R1-32B

本手册提供了 Ollama 和 Open WebUI 的安装和使用指南,支持deepseek r1版本

2

20元/小时

v1.0

Ollama-DeepSeek-R1-32B

1. 引言

本手册旨在指导用户如何安装和使用 Ollama 和 Open WebUI,以便更好地利用深度学习模型进行推理和交互。

2. 运行 Ollama

在终端中执行以下命令以启动 Ollama 服务:

ollama serve

如需通过cherrystudio、dify等本地工具配置连接Ollama,则启动命令修改如下

API地址填写为:外网IP地址:11434,同时本地工具中模型名称填写为:deepseek-r1:32b

export OLLAMA_HOST=0.0.0.0:11434

ollama serve

3. 运行模型(可选)

接下来,您可以安装并运行指定的深度学习模型。以下是安装和运行 deepseek-r1:32b 模型的命令:

ollama run deepseek-r1:32b

4. 启动 Open WebUI

启动 Open WebUI 服务,指定端口和主机:

open-webui serve --port 6080 --host 0.0.0.0

5. 用户名和密码设置

在启动 Open WebUI 后,您需要设置用户名和密码。请按以下步骤进行设置:

- 创建用户名和密码,均设置为

123。邮箱为:pony@123.com

6. 常见问题解答

Q1: 如何确认 Ollama 和 Open WebUI 是否成功启动?

您可以在终端中查看输出信息,确认没有错误信息,并且可以通过浏览器访问指定的地址(例如 http://localhost:6080)来检查 Open WebUI 是否正常工作。

Q2: 如果遇到安装问题,我该怎么办?

请确保您的 Python 和 pip 版本是最新的,并且网络连接正常。您可以尝试使用 pip install --upgrade pip 命令来升级 pip。

Q3:如果Web端打不开怎么办

多刷新几次,这个docker显示的web端有点问题

扫码加入DeepSeek使用交流群

@敢敢のwings 认证作者

认证作者

认证作者

认证作者

镜像信息

已使用1385 次

运行时长

1068 H

镜像大小

20GB

最后更新时间

2025-07-02

支持卡型

RTX40系20803080Ti309048G RTX40系2080TiH20A800P40A100RTX50系V100S

+12

框架版本

CUDA版本

12.1

应用

JupyterLab: 8888

自定义开放端口

6080

+1

版本

v1.0

2025-07-02