DeepScaleR-1.5B

Deepseek-R1-Distilled-Qwen-1.5B,通过简单的强化学习(RL)微调,得到了全新的DeepScaleR-1.5B-Preview。

在AIME2024基准中,模型的Pass@1准确率达高达43.1% ——不仅比基础模型提高了14.3%,而且在只有1.5B参数的情况下超越了OpenAI o1-preview!

0

00元/小时

v1.0

DeepScaleR-1.5B 镜像使用教程

环境准备

在 compshare 平台中租用一台配置为 3090 或以上显存(24G)*2的显卡机器。镜像选择如下:

- PyTorch: 2.0.0

- Python: 3.8 (ubuntu20.04)

- CUDA: 11.8(11.3 版本以上均可)

接下来,打开刚刚租用的服务器的 JupyterLab,并启动其中的终端开始环境配置、模型下载和运行演示。

镜像快速使用教程

1. 待实例初始化完成后,在控制台-应用中打开”JupyterLab“

2. 进入Jupyter后,新建一个终端Terminal,输入以下指令

streamlit run /root/compshare-tmp/chatBot.py --server.address 0.0.0.0 --server.port 11434

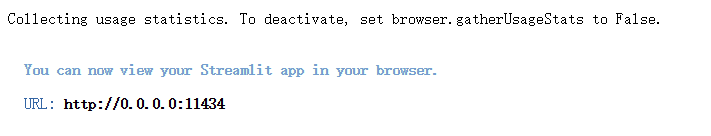

3. 运行出现如下结果时,即可在浏览器中访问 http://0.0.0.0:11434 ,其中0.0.0.0替换为外网ip,外网ip可以在控制台-基础网络(外)中获取

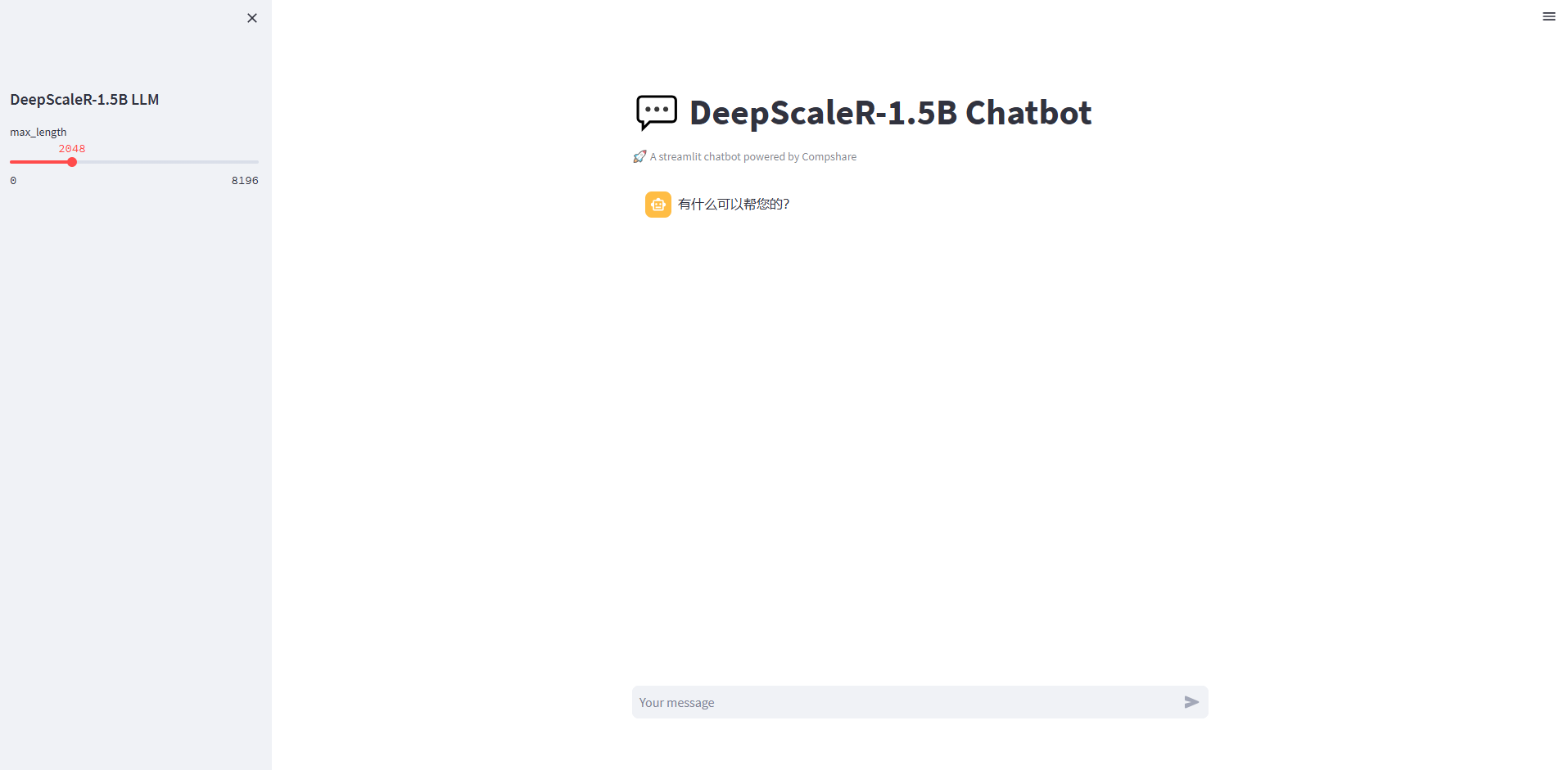

成功进入web界面如下图所示

pip换源和安装依赖包

# 升级pip

python -m pip install --upgrade pip

# 更换 pypi 源加速库的安装

pip config set global.index-url https://pypi.tuna.tsinghua.edu.cn/simple

# 安装依赖包

pip install modelscope==1.9.5

pip install transformers==4.48.3

pip install streamlit==1.24.0

pip install sentencepiece==0.1.99

pip install accelerate==1.3.0

pip install transformers_stream_generator==0.0.4

模型下载

使用 modelscope 中的 snapshot_download 函数下载模型。以下是下载模型的步骤:

- 在

/root/compshare-tmp路径下新建download.py文件,并将以下代码粘贴进去:

import torch

from modelscope import snapshot_download

import os # Optional for faster downloading

os.environ["HF_HUB_ENABLE_HF_TRANSFER"] = "1"

model_dir = snapshot_download('agentica-org/DeepScaleR-1.5B-Preview', cache_dir='/root/compshare-tmp')

- 保存文件,并运行以下命令执行下载(模型大小为 15 GB,下载时间大约需要 10~20 分钟):

python /root/compshare-tmp/download.py

代码准备

在 /root/compshare-tmp 路径下新建 chatBot.py 文件,并将以下代码粘贴进去:

# 导入所需的库

from transformers import AutoTokenizer, AutoModelForCausalLM, GenerationConfig

import torch

import streamlit as st

# 在侧边栏中创建一个标题和一个链接

with st.sidebar:

st.markdown("## DeepScaleR-1.5B LLM")

max_length = st.slider("max_length", 0, 8196, 1024, step=1)

# 创建一个标题和一个副标题

st.title("💬 DeepScaleR-1.5B Chatbot")

st.caption("🚀 A streamlit chatbot powered by Compshare")

# 定义模型路径

mode_name_or_path = '/root/compshare-tmp/agentica-org/DeepScaleR-1.5B-Preview'

# 定义一个函数,用于获取模型和tokenizer

@st.cache_resource

def get_model():

tokenizer = AutoTokenizer.from_pretrained(mode_name_or_path, trust_remote_code=True)

model = AutoModelForCausalLM.from_pretrained(mode_name_or_path, trust_remote_code=True, torch_dtype=torch.bfloat16, device_map="auto")

model.generation_config = GenerationConfig.from_pretrained(mode_name_or_path)

model.eval()

return tokenizer, model

# 加载Baichuan-7B-chat的model和tokenizer

tokenizer, model = get_model()

if "messages" not in st.session_state:

st.session_state["messages"] = [{"role": "assistant", "content": "有什么可以帮您的?"}]

for msg in st.session_state.messages:

st.chat_message(msg["role"]).write(msg["content"])

if prompt := st.chat_input():

st.session_state.messages.append({"role": "user", "content": prompt})

st.chat_message("user").write(prompt)

input_tensor = tokenizer.apply_chat_template(st.session_state.messages, add_generation_prompt=True, return_tensors="pt")

outputs = model.generate(input_tensor.to(model.device), max_new_tokens=max_length)

response = tokenizer.decode(outputs[0][input_tensor.shape[1]:], skip_special_tokens=True)

st.session_state.messages.append({"role": "assistant", "content": response})

st.chat_message("assistant").write(response)

运行 Demo

在终端中运行以下命令启动 streamlit 服务,并按照 compshare 的指示将端口映射到本地,然后在浏览器中打开链接 http://localhost:6006/,即可看到聊天界面。

streamlit run /root/compshare-tmp/chatBot.py --server.address 0.0.0.0 --server.port 11434

@敢敢のwings 认证作者

认证作者

认证作者

认证作者

镜像信息

已使用13 次

运行时长

2 H

镜像大小

50GB

最后更新时间

2025-07-03

支持卡型

RTX40系20803080Ti309048G RTX40系2080TiH20A800P40A100RTX50系V100S

+12

框架版本

CUDA版本

11.8

应用

JupyterLab: 8888

版本

v1.0

2025-07-03