0

0GLM-4-0414

介绍

智谱GLM 家族迎来新一代开源模型 GLM-4-32B-0414 系列,320 亿参数,效果比肩 OpenAI 的 GPT 系列和 DeepSeek 的 V3/R1 系列,且支持非常友好的本地部署特性。GLM-4-32B-Base-0414 经过 15T 高质量数据的预训练,其中包含大量推理类的合成数据,这为后续的强化学习扩展打下了基础。在后训练阶段,除了针对对话场景进行了人类偏好对齐外,我们还通过拒绝采样和强化学习等技术强化了模型在指令遵循、工程代码、函数调用方面的效果,加强了智能体任务所需的原子能力。GLM-4-32B-0414 在工程代码、Artifacts 生成、函数调用、搜索问答及报告等方面都取得了不错的效果,部分 Benchmark 甚至可以媲美更大规模的 GPT-4o、DeepSeek-V3-0324(671B)等模型。

GLM-Z1-32B-0414 是具有深度思考能力的推理模型,这是在 GLM-4-32B-0414 的基础上,通过冷启动和扩展强化学习,以及在数学、代码和逻辑等任务上对模型的进一步训练得到的。相对于基础模型,GLM-Z1-32B-0414 显著提升了数理能力和解决复杂任务的能力。在训练的过程中,我们还引入了基于对战排序反馈的通用强化学习,进一步增强了模型的通用能力。

GLM-Z1-Rumination-32B-0414 是具有沉思能力的深度推理模型(对标 Open AI 的 Deep Research)。不同于一般的深度思考模型,沉思模型通过更长时间的深度思考来解决更开放和复杂的问题(例如:撰写两个城市AI发展对比情况,以及未来的发展规划),沉思模型在深度思考过程中结合搜索工具处理复杂任务,并经过利用多种规则型奖励来指导和扩展端到端强化学习训练得到。Z1-Rumination 在研究型写作和复杂检索任务上的能力得到了显著提升。

最后,GLM-Z1-9B-0414 是一个惊喜。我们沿用上述一系列技术,训练了一个保持开源传统的 9B 小尺寸模型。尽管规模更小,GLM-Z1-9B-0414 在数学推理和通用任务中依然展现出极为优秀的能力,其整体表现已处于同尺寸开源模型中的领先水平。特别是在资源受限的场景下,该模型在效率与效果之间实现了出色的平衡,为追求轻量化部署的用户提供了强有力的选择。

官方介绍页:https://github.com/THUDM/GLM-4/blob/main/README_zh.md

模型列表

| Model | Type | Seq Length* | Download |

|---|---|---|---|

| GLM-4-9B-0414 | Chat | 32K -> 128K | 🤗 Huggingface 🤖 ModelScope 🧩 Modelers |

| GLM-Z1-9B-0414 | Reasoning | 32K -> 128K | 🤗 Huggingface 🤖 ModelScope 🧩 Modelers |

| GLM-4-32B-Base-0414 | Base | 32K -> 128K | 🤗 Huggingface 🤖 ModelScope 🧩 Modelers |

| GLM-4-32B-0414 | Chat | 32K -> 128K | 🤗 Huggingface 🤖 ModelScope 🧩 Modelers |

| GLM-Z1-32B-0414 | Reasoning | 32K -> 128K | 🤗 Huggingface 🤖 ModelScope 🧩 Modelers |

| GLM-Z1-Rumination-32B-0414 | Reasoning | 128K | 🤗 Huggingface 🤖 ModelScope 🧩 Modelers |

上面所有模型都以下载在/model/HuggingFace/THUDM中

使用方法

资源提示:9B-单卡4090/3090可跑 32B需要4卡哦!

启动open-webui

本实例安装好了open-webui,可以实现可视化对话. 1.创建实例

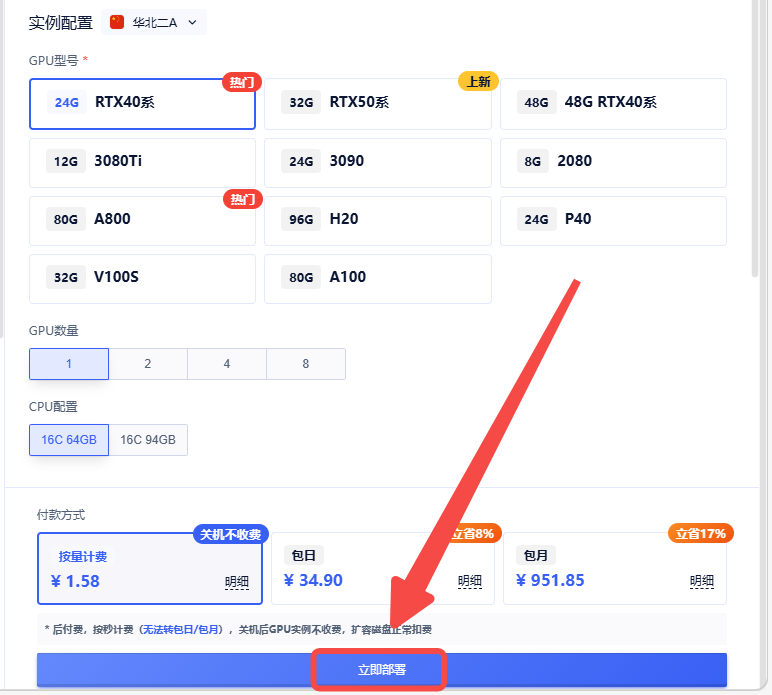

2.选择合适的机型,立即部署

3. 待实例初始化完成后,在控制台-应用中打开“JupyterLab”,进入JupyterLab后新建一个终端,运行以下指令

3. 待实例初始化完成后,在控制台-应用中打开“JupyterLab”,进入JupyterLab后新建一个终端,运行以下指令

open-webui serve

-

当运行结果如下图所示时,即可在浏览器中访问open-webui:http://{你的实例ip}:8080/ ;实例ip可以在控制台-基础网络(外)中获取

-

成功访问web界面如下图所示,登录open-webui 账号: root@root.com 密码: root

再开一个终端,运行vllm

GLM-Z1-9B-0414部署命令示例

vllm serve /model/HuggingFace/THUDM/GLM-Z1-9B-0414/ --model-impl transformers --tensor-parallel-size 1

其他版本可运行以下命令,大模型路径替换为需要运行的模型路径

vllm serve {大模型路径} --model-impl transformers --tensor-parallel-size {GPU数}

下载好的大模型在/model/HuggingFace/THUDM/下,可自行替换模型(请按照正确的格式替换)

vllm模型加载速度比较慢,请耐心等该

登录并配置open-webui

1、登录open-webui之后,在右上角的头像,在弹出的菜单中点击 设置

2、在弹出的设置中点击** 管理员设置 ,然后点击外部连接**

3、在管理OpenAI API连接中,点击右边的小齿轮,修改ip为你创建的实例的ip(复制实例的BGP),只需要替换ip的内容,其余不需要任何更改,点击保存

4、点击新对话,刷新页面,即可看到vllm部署的大模型

注:更换模型需要停止运行vllm -> 修改{大模型路径} -> 重新运行vllm -> 刷新open-webui页面

认证作者

认证作者