Qwen3-vLLM-Series

Qwen3系列模型,单卡4090推荐0.6B-8B模型,2卡推荐14B模型,4卡推荐32B模型

4

40元/小时

v1.0

Qwen3系列大模型集合

此次主要推出了Qwen3系列模型,及其使用方式。单卡4090推荐0.6B-8B模型,2卡推荐14B模型,4卡推荐32B模型。

操作步骤

1. 先选择GPU型号,再选择GPU数量,再点击“立即部署”

2. 待实例初始化完成后,在控制台-应用中点击“JupyterLab”进入,新建一个终端Terminal,在终端Terminal中根据选取的GPU型号和数量输入模型启动命令

推荐配置1卡4090

# Qwen3-0.6B

VLLM_USE_MODELSCOPE=1 vllm serve /model/ModelScope/Qwen/Qwen3-0.6B -tp 1 --enable-reasoning --reasoning-parser deepseek_r1

# Qwen3-1.7B

VLLM_USE_MODELSCOPE=1 vllm serve /model/ModelScope/Qwen/Qwen3-1.7B -tp 1 --enable-reasoning --reasoning-parser deepseek_r1

# Qwen3-4B

VLLM_USE_MODELSCOPE=1 vllm serve /model/ModelScope/Qwen/Qwen3-4B -tp 1 --enable-reasoning --reasoning-parser deepseek_r1

# Qwen3-8B

vllm serve /model/ModelScope/Qwen/Qwen3-8B -tp 1 --enable-reasoning --reasoning-parser deepseek_r1 --max-model-len 20480

推荐配置 2卡4090

# Qwen3-14B

VLLM_USE_MODELSCOPE=1 vllm serve /model/ModelScope/Qwen/Qwen3-14B -tp 2 --enable-reasoning --reasoning-parser deepseek_r1

推荐配置 4卡4090

# Qwen3-32B

VLLM_USE_MODELSCOPE=1 vllm serve /model/ModelScope/Qwen/Qwen3-32B -tp 4 --enable-reasoning --reasoning-parser deepseek_r1

交互方式

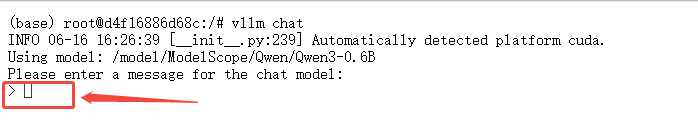

1.命令行交互

等待对应模型启动后,新开终端Terminal进行交互,输入以下指令

vllm chat

启动后,即可在Terminal中输入与模型进行交互

2.open-webui交互

等待对应模型启动后,新开终端Terminal,输入以下指令启动open-webui 服务

conda activate openwebui

open-webui serve --port 8080

通过浏览器访问:http://ip:8080 ,ip替换为虚机实例的外网ip,登陆邮箱:ucloud@ucloud.cn 密码:ucloud.cn

扫码加入优云智算使用交流群

@优云智算

镜像信息

已使用168 次

运行时长

1208 H

镜像大小

70GB

最后更新时间

2025-07-03

支持卡型

RTX40系20803080Ti309048G RTX40系2080TiH20A800P40A100RTX50系V100SV100S

+13

框架版本

CUDA版本

12.4

应用

JupyterLab: 8888

自定义开放端口

8080

+1

版本

v1.0

2025-07-03