Text-Generation-Webui

Text-Generation-Webui大语言模型综合终端。

1

10元/小时

v1.0

Text generation web UI

镜像简介

本镜像搭载集成的Text-Generation-WebUI综合界面,提供图形化操作环境以加载、管理并交互使用多种大语言模型。支持模型加载、参数调整、对话交互及文本生成等核心功能,适用于开发者模型测试、研究人员实验验证及普通用户进行便捷的AI文本创作与对话,显著降低大模型使用门槛。 Text-Generation-Webui大语言模型综合终端。Text-Generation-Webui 是 oobabooga 开发的开源 LLM 前端,被誉为“文本界的 AUTOMATIC1111”,支持 llama.cpp、Transformers、ExLlamaV3、TensorRT-LLM 等多种后端

原始项目仓库: https://github.com/oobabooga/text-generation-webui

一个基于 Gradio 的大语言模型加载平台。

预装模型:DeepSeek-R1-0528-Qwen3-8B-Q8_0,Qwen3-8b-Q8_0,Gemma2-27b-Q4_k_m

内置模型下载源已替换为hf-mirror.com

特点

- 多种加载器支持: 在一个 UI/API 中支持多种文本生成后端,包括 llama.cpp, Transformers, ExLlamaV3, ExLlamaV2, 和 TensorRT-LLM 。

- 简易设置:。

- 自动提示格式化: 使用 Jinja2 模板进行自动提示格式化,您无需担心提示格式。

- 美观的 UI: 提供深色和浅色主题。

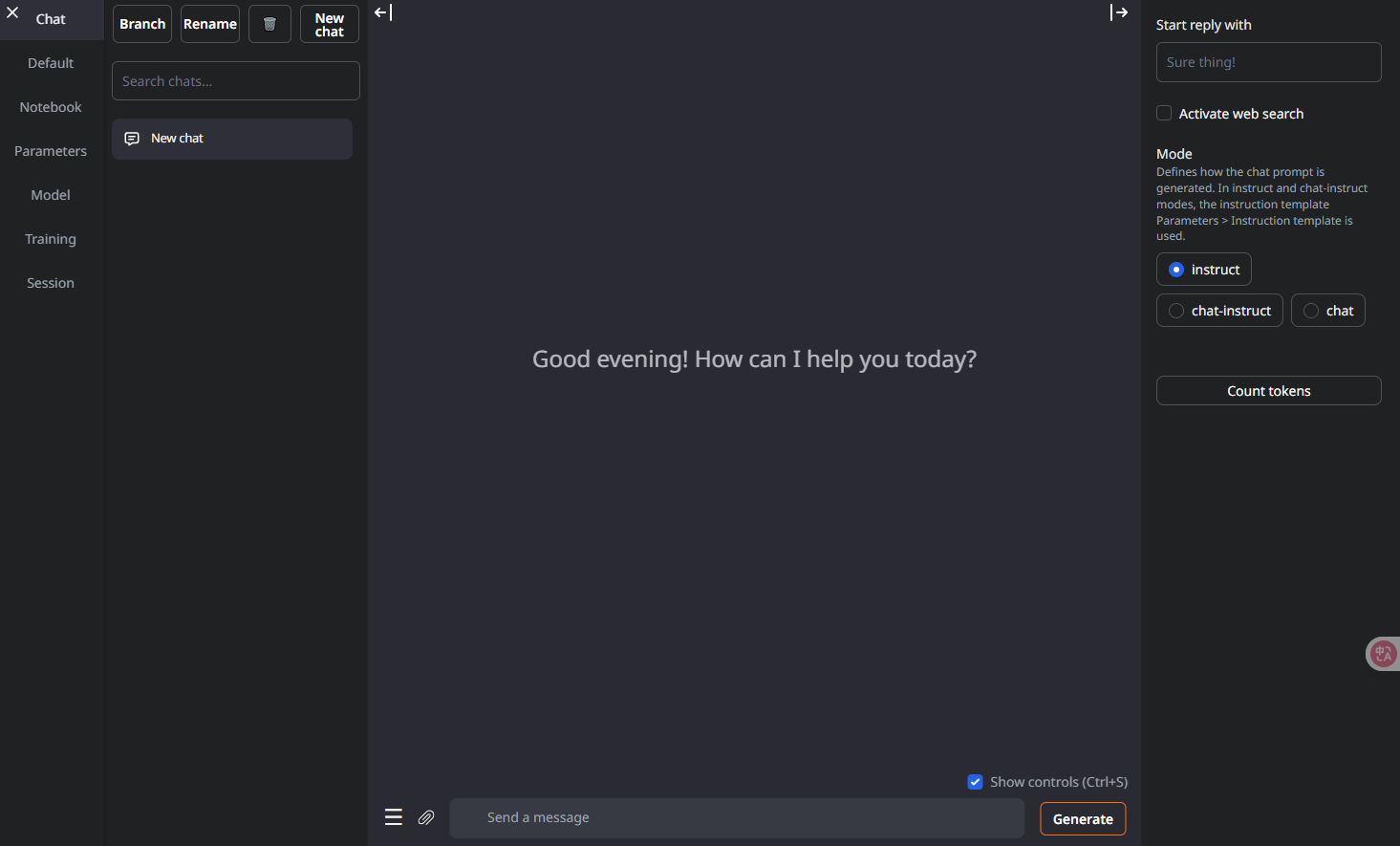

- 多种模式:

- 指令模式 (instruct mode): 用于遵循指令 (类似于 ChatGPT)。

- 聊天-指令/聊天模式 (chat-instruct/chat modes): 用于与自定义角色对话。

- 对话管理: 编辑消息,在消息版本之间导航,并在任何时候分支对话。

- 丰富的生成参数: 提供多种采样参数和生成选项,用于复杂的文本生成控制。

- 无需重启切换模型: 在 UI 中无需重启即可切换不同的模型。

- GGUF 模型自动 GPU 层: 对于 NVIDIA GPU 上的 GGUF 模型,支持自动 GPU 层。

- 自由形式文本生成: 在 Default/Notebook 选项卡中进行自由形式文本生成,不受聊天回合限制。

- OpenAI 兼容 API: 提供与 OpenAI 兼容的 API,包含 Chat 和 Completions 端点,支持工具调用 – 查看 示例。

- 扩展支持: 提供丰富的内置和用户贡献的扩展。详细信息请参阅 wiki 和 extensions 目录。

使用方法

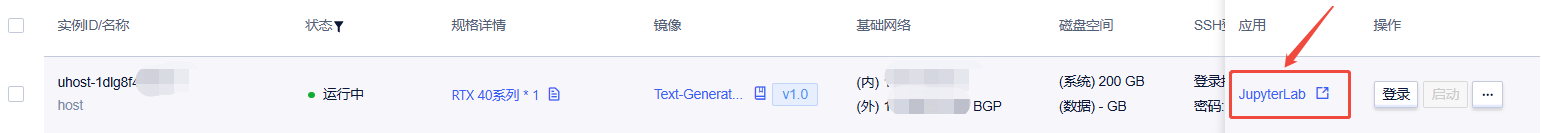

待实例初始化完成后,在控制台-应用中打开“JupyterLab”

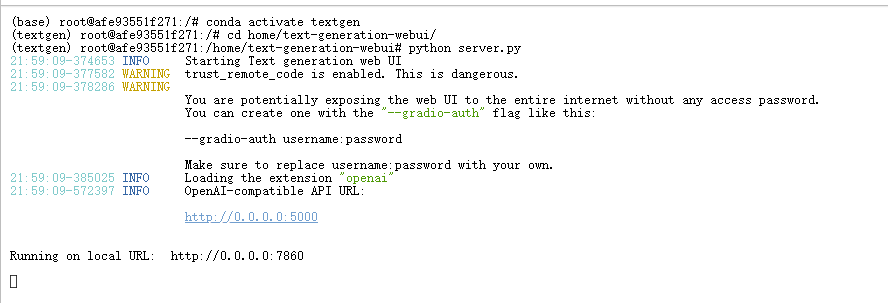

进入JupyterLab后,新建一个终端Terminal,在终端中依次输入如下指令

conda activate textgen

cd home/text-generation-webui/

python server.py

程序启动后你应该会看见如下内容

此时即可在浏览器中通过 外网ip:7860 访问WebUI界面

Text Generation WebUI的网页gradio端口。所有模型下载,加载与模型参数调整都可以在WebUI内完成

WebUI详细使用教程: https://www.bilibili.com/video/BV1ZC4y1T7qj/

API调用

openai标准API接口地址:服务器外网ip:5000

@Smzh 认证作者

认证作者

认证作者

认证作者

镜像信息

已使用10 次

运行时长

96 H

镜像大小

90GB

最后更新时间

2026-02-03

支持卡型

RTX40系20803080Ti309048G RTX40系2080TiH20A800P40A100RTX50系V100SV100S

+13

框架版本

CUDA版本

12.4

应用

JupyterLab: 8888

自定义开放端口

78605000

+2

版本

v1.0

2026-02-03