TabbyAPI

TabbyAPI 是 ExLlamaV2 官方开源的高性能文本生成服务器,OpenAI 兼容、轻量极速,支持 Exl2/GPTQ/FP16 模型,内置并发批处理、LoRA 热插、工具调用与草稿推测解码

0

00元/小时

v1.0

TabbyAPI LLM高效推理项目

镜像简介

本镜像提供开源的本地大语言模型API服务TabbyAPI,兼容OpenAI API格式,支持连接多种开源模型并在本地或私有环境中部署。提供标准化的Chat与Completions接口,便于开发者快速集成AI能力,适用于聊天应用、智能助手及各类需要本地化、可定制大模型服务的开发场景,实现高效灵活的后端对接。

原始项目仓库: https://github.com/theroyallab/tabbyAPI

一个基于 Exllamav2 的高性能大语言模型 API 和加载平台。

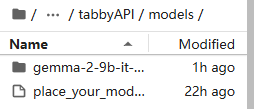

预装模型: gemma-2-9b-it-exl2-4.5bpw

特点

OpenAI 兼容 API: 提供与 OpenAI 兼容的 API,包含 Chat 和 Completions 端点,支持工具调用。

灵活模板引擎: 使用灵活的 Jinja2 模板引擎进行聊天补全,符合 HuggingFace 标准。

异步并发推理: 利用 asyncio 实现并发推理。

高级控制: 支持 JSON schema + Regex + EBNF,提供更精细的生成控制。

AI Horde 支持: 集成 AI Horde。

连续批处理: 使用分页注意力实现连续批处理引擎。

快速无分类器引导: 支持快速无分类器引导。

支持模型类型

Exl2

GPTQ

FP16(使用ExllamaV2加载)

官方wiki

https://github.com/theroyallab/tabbyAPI/wiki/

使用方法

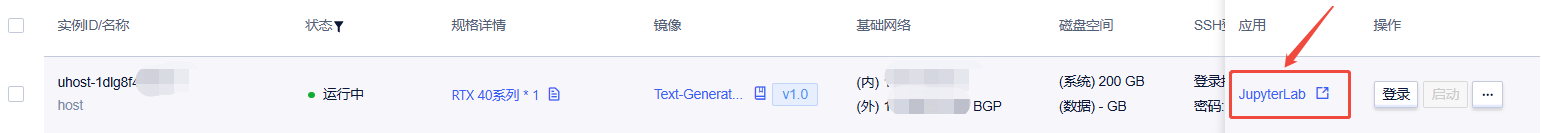

待实例初始化完成后,在控制台-应用中打开“JupyterLab”

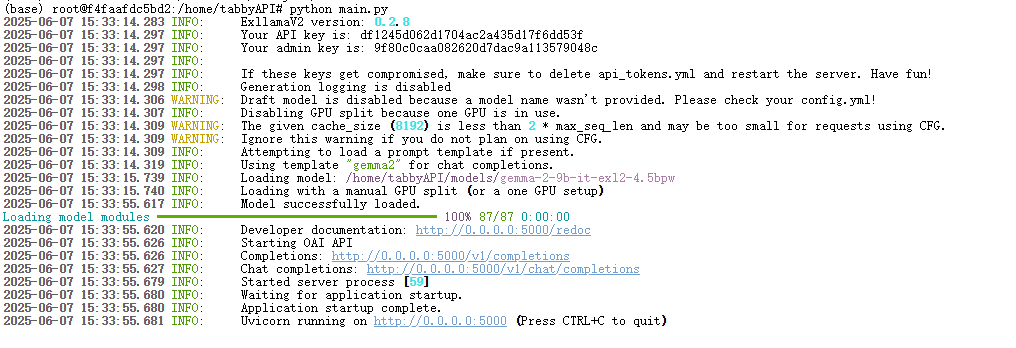

依次输入如下指令

cd home/tabbyAPI/

python main.py

程序启动后你应该会看见如下内容

默认自动加载自带的gemma-2-9b模型,apikey为自动随机生成

如果需要切换模型,需要首先将可用模型放置到tabbyapi目录下models文件夹内

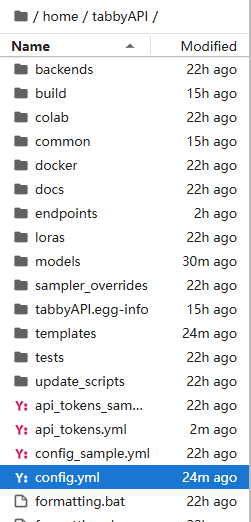

放置完成后,进入tabbyapi目录找到config.yml文件

进入后调整模型加载参数,并加载。

具体流程请参考wiki以及config内自带的说明

可参考的视频教程:

https://www.bilibili.com/video/BV1U2XrYTEhx/?

API调用

openai标准API接口地址:服务器外网ip:5000

@Smzh 认证作者

认证作者

认证作者

认证作者

镜像信息

已使用4 次

运行时长

25 H

镜像大小

70GB

最后更新时间

2026-02-03

支持卡型

RTX40系20803080Ti309048G RTX40系2080TiH20A800P40A100RTX50系V100SV100S

+13

框架版本

CUDA版本

12.4

应用

JupyterLab: 8888

自定义开放端口

5000

+1

版本

v1.0

2026-02-03