LlamaFactory纯净版-微调使用

在conda环境下仅安装了LlamaFactory,以及llama.cpp,llama.cpp未编译,可用convert.py来导出gguf模型文件

5

50.01元/小时

v1.1

LLaMA-Factory 微调镜像-纯净版(可直接开启web'ui微调)

纯净环境镜像,预装LLaMA-Factory和llama.cpp,支持快速启动WebUI进行模型微调,使用Conda管理Python环境。(节省想要用来微调的友友们搭环境时间)

🌟 镜像内容

- 核心组件:

- LLaMA-Factory (最新版)

- llama.cpp (模型转换工具)

- 环境管理:

- Miniconda3 (Python 3.10+)

- 预创建conda环境

llamafactoryllamacpp

- WebUI支持:

- 已配置端口转发

- 依赖项预装完成

🚀 快速开始

启动示例

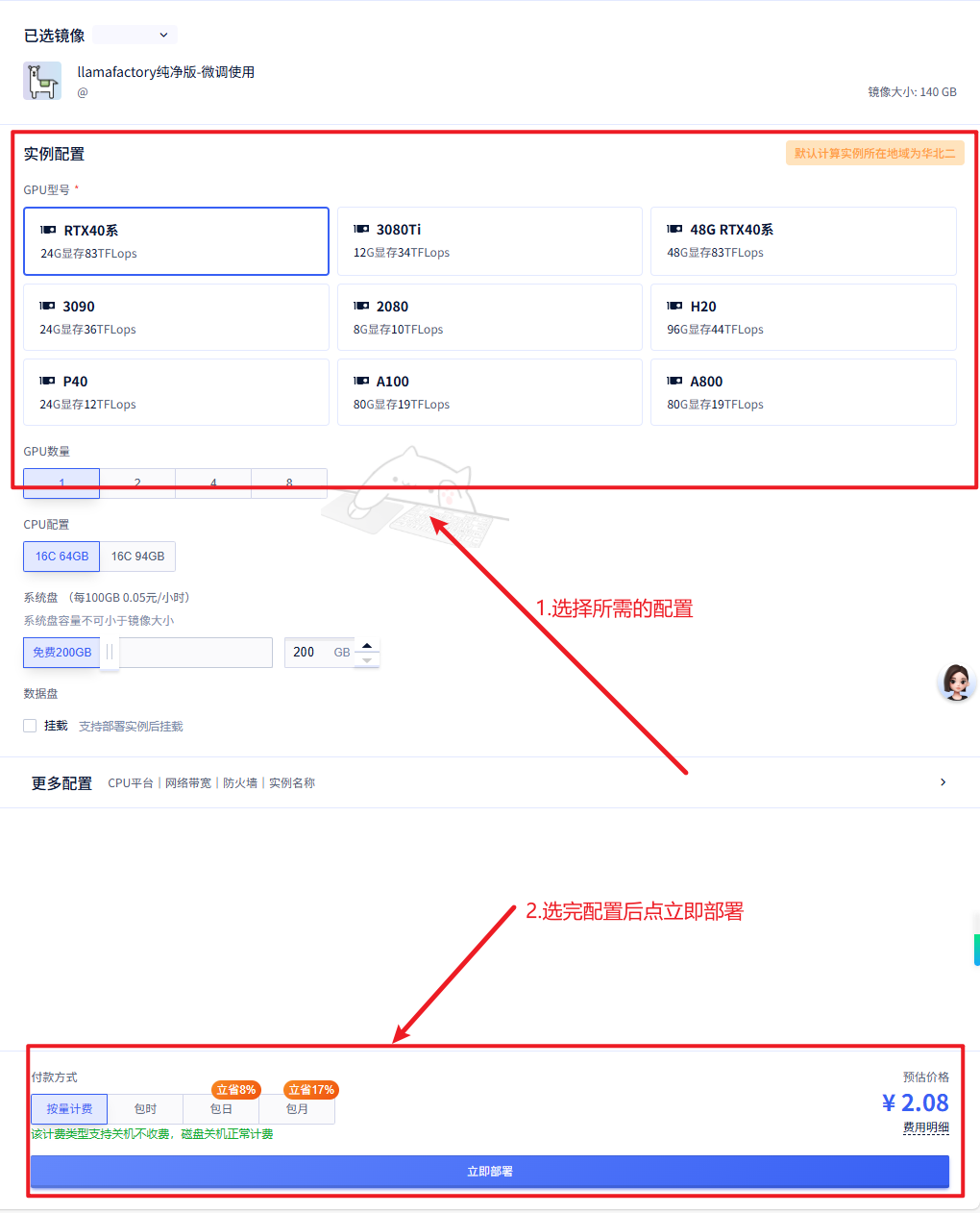

1、选择WYSLOVE的云端镜像创建实例

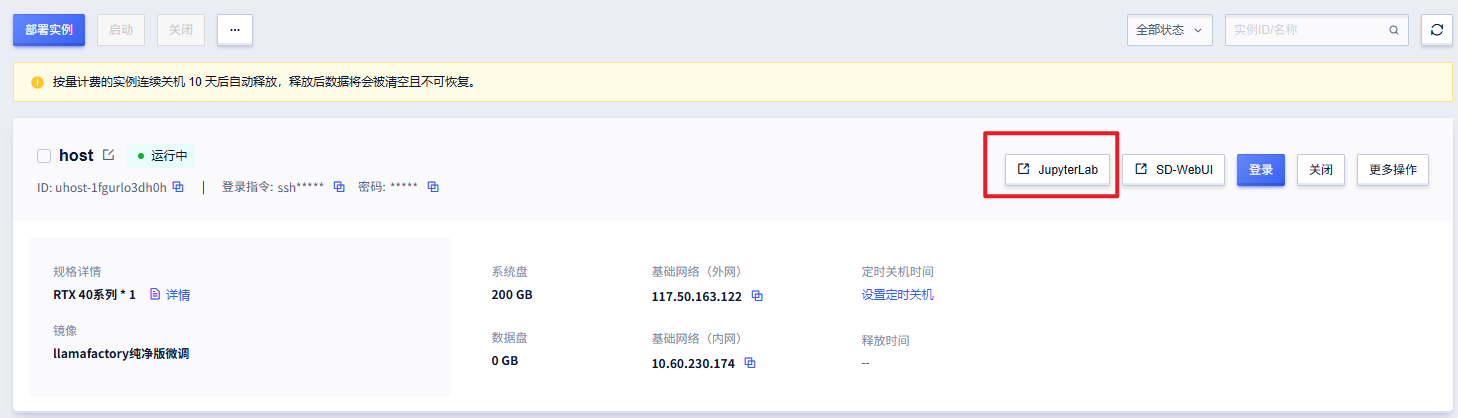

2、选择完显卡型号后点击立即部署,推荐使用4090,然后点击JupyterLab

开启微调

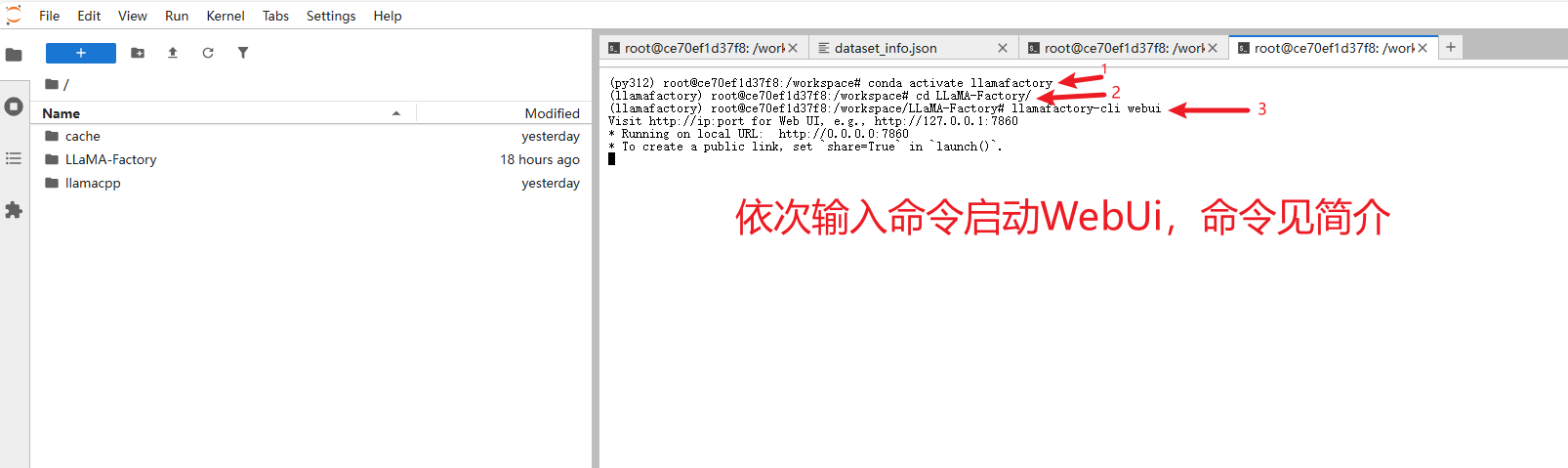

1. 启动WebUI

命令如下

conda activate llamafactory

cd LLaMA-Factory/

llamafactory-cli webui

开启后

➡ 访问 http://<服务器外网IP>:7860 (推荐Chrome/Firefox)

也可点击SD-WebUI进入WebUI界面

↓↓↓

↓↓↓

2. 模型转换(示例)

conda activate llamafactory #可以直接使用llamafactory这个环境来转换模型

cd /path/to/llama.cpp

python convert-hf-to-gguf.py Qwen/Qwen3-8B --outtype bf16 --outfile Qwen3-8B-BF16.gguf

转换后可自行部署

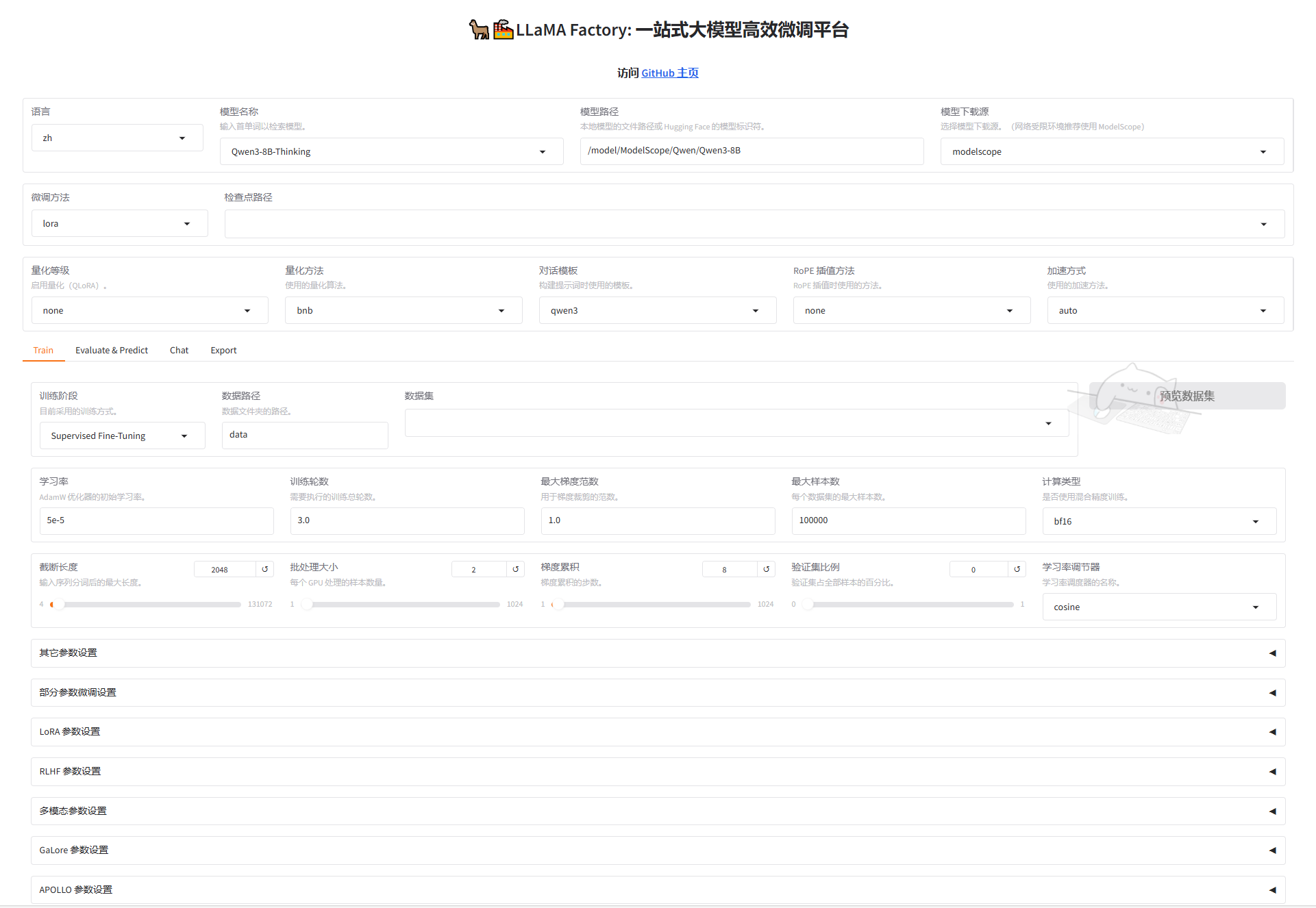

注意:微调模型可以直接用平台路径下的,省出自己pull模型时间。详可查阅官方文档。路径为/model/ModelScope......

⚙ 查看GPU状态 nvidia-smi -l

📦 目录结构

/workspace

├── LLaMA-Factory/ # 微调纯净版

├── llamacpp/ # 模型转换工具

📚 扩展资源

@WYSLOVE

镜像信息

已使用154 次

运行时长

2140 H

镜像大小

140GB

最后更新时间

2025-08-12

支持卡型

RTX40系20803080Ti309048G RTX40系2080TiH20A800P40A100RTX50系V100S

+12

框架版本

CUDA版本

12.8

应用

JupyterLab: 8888

版本

v1.1

2025-08-12