OpenAI-GPT-OSS-120B/20B

OpenAI正式发布了其首个开源大语言模型系列——gpt-oss,这标志着自GPT-2以来OpenAI首次将其核心模型技术开源。

3

30元/小时

v1.0

Open AI开源模型GPT-OSS部署使用教程

镜像简介

OpenAI正式发布了其首个开源大语言模型系列——gpt-oss,这标志着自GPT-2以来OpenAI首次将其核心模型技术开源。gpt-oss系列包含两个主要版本:gpt-oss-20b和gpt-oss-120b,分别针对不同的应用场景和硬件配置进行了优化。 本镜像基于OpenAI首个开源大语言模型系列GPT-OSS,提供120B和20B双参数版本,具备强大的文本生成、理解与推理能力。该镜像的发布标志着OpenAI大模型技术的首次开放,适用于学术研究、多轮对话、内容创作及下游任务开发等场景,为开发者与研究机构提供官方、可靠的开源大模型部署环境。

-

注意:120b模型默认需要70G显存,推荐4090(48G)*2,20b模型可用4090(24G)单卡运行。

-

本镜像已做好70b模型自启动,直接复制外网ip:5678到浏览器即使用,账户名ucloud@163.com, 密码为ucloud

-

如需使用20b模型可以参考文章或下方readme来修改

详细可以参考:https://hermit.blog.csdn.net/article/details/149959729

使用教程

Ollama提供了多种使用方式,包括命令行、API接口和Web界面。

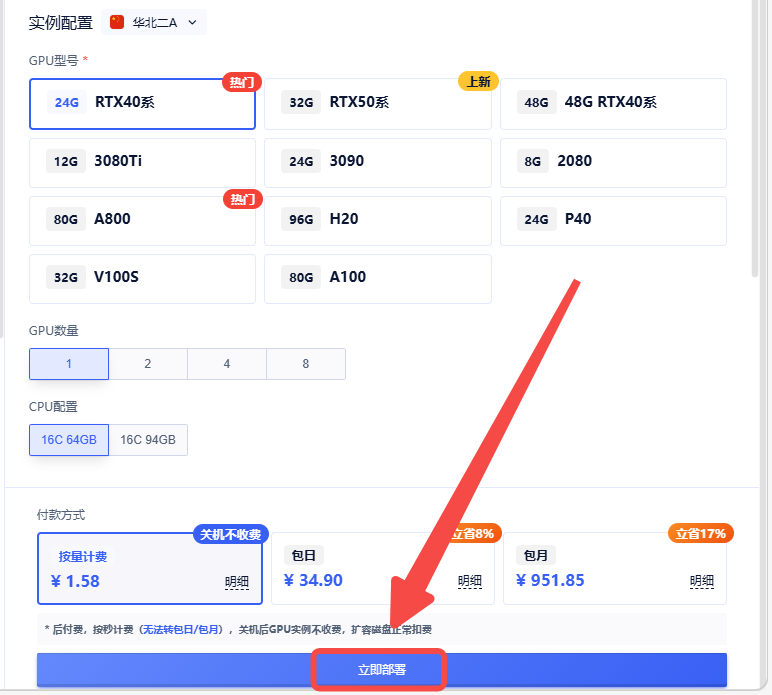

创建实例

选择合适的机型,立即部署

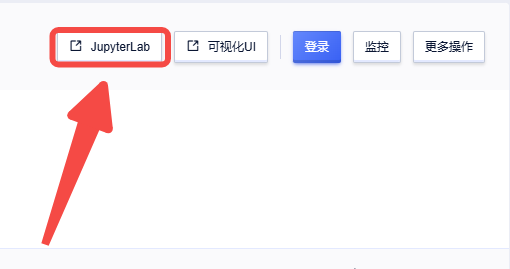

实例创建后,进入jupyterlab,运行命令行启动ollama服务

实例创建后,进入jupyterlab,运行命令行启动ollama服务

ollama服务启动

ollama run gpt-oss:20b

交互式对话

# 单次查询

ollama run gpt-oss:20b "Explain the concept of machine learning in simple terms."

# 流式输出

ollama run gpt-oss:20b --stream "Write a Python function to calculate fibonacci numbers."

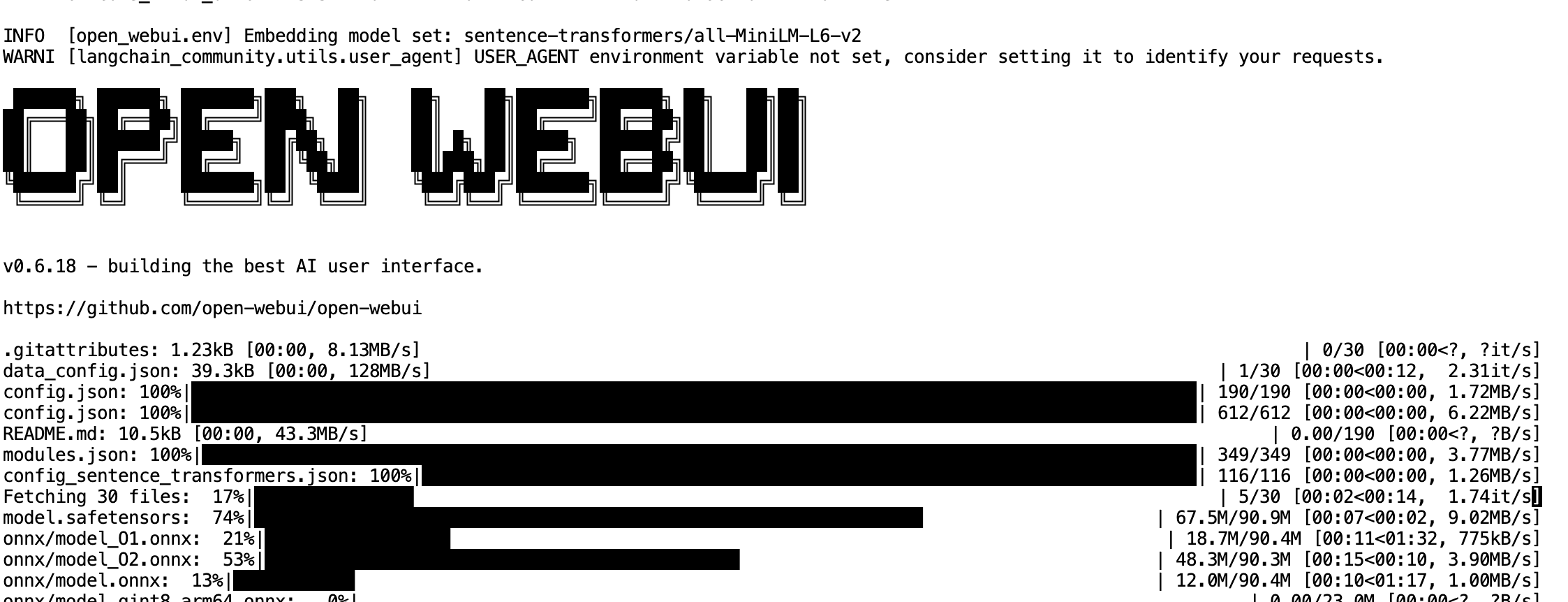

可视化使用open-webui

新开terminal,执行如下命令

pip install open-webui

open-webui serve --port 5678 --host 0.0.0.0

账户名ucloud@163.com, 密码为ucloud

@敢敢のwings 认证作者

认证作者

认证作者

认证作者

镜像信息

已使用29 次

运行时长

98 H

镜像大小

140GB

最后更新时间

2026-02-02

支持卡型

RTX40系20803080Ti309048G RTX40系2080TiH20A800P40A100RTX50系V100SV100S

+13

框架版本

CUDA版本

12.1

应用

JupyterLab: 8888

自定义开放端口

5678

+1

版本

v1.0

2026-02-02