2

2magic-tryon图片视频虚拟试装换装模特换衣 二次webui开发构建by科哥

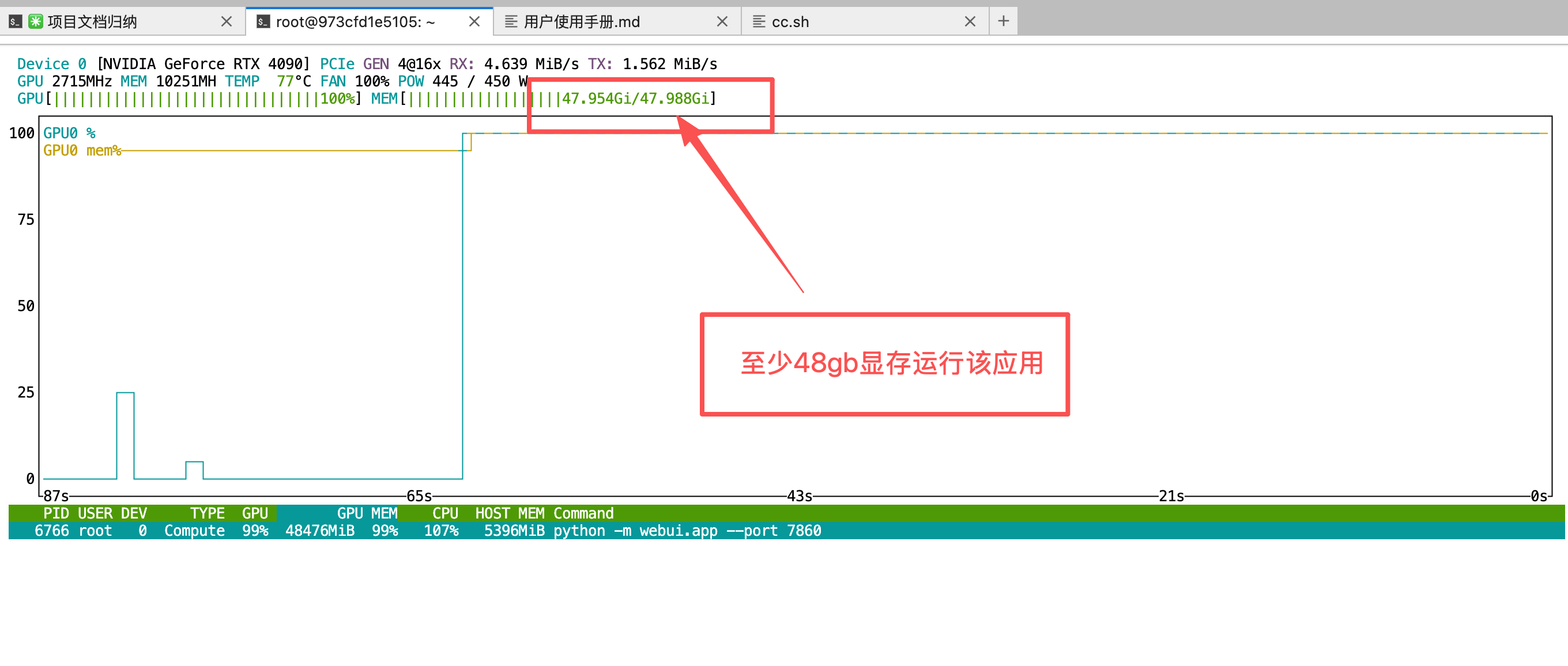

需要48gb显卡最少运行这个镜像

镜像简介

本镜像基于Vivo开源的Magic-Tryon虚拟试装模型,支持通过WebUI界面在图片或视频中实现高真实感的衣物更换与试穿效果。适用于电商展示、时尚设计、娱乐互动及个性化内容创作等场景,为用户提供便捷、直观的虚拟换装体验,有效降低实拍成本,提升视觉呈现效率。

镜像使用教程

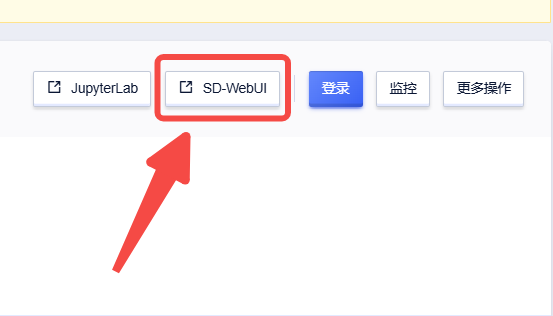

创建实例后点击【SD-WebUI】即可进入操作页面

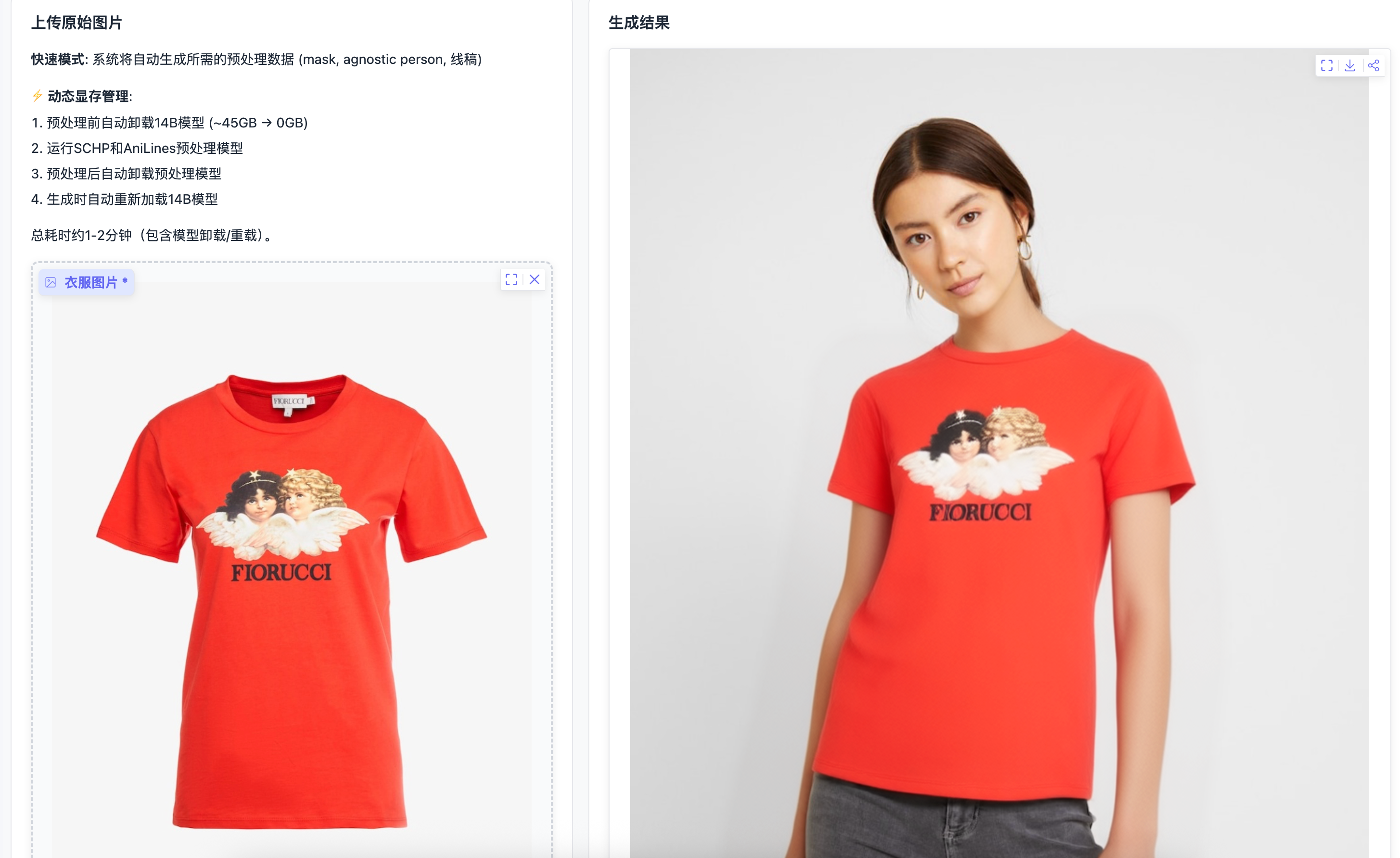

运行webui截图界面:

bug反馈可以加入科哥专属群交流➕ 广告勿进!

科哥在UCloud镜像列表【不断更新中】:

MagicTryOn 用户使用手册

本手册介绍 MagicTryOn 虚拟试穿系统的使用方法,帮助用户快速上手。

一、系统简介

MagicTryOn 是一个基于 AI 的虚拟试穿系统,可以将衣服图片"穿"到人物图片/视频上,生成逼真的试穿效果。

功能特点

- 快速试穿: 上传原始图片,系统自动生成预处理数据(推荐新手)

- 图片试穿: 使用预处理数据进行图片试穿

- 视频试穿: 使用预处理数据进行视频试穿

- 自定义试穿: 高级功能,包含预处理工具引导

二、界面概览

启动系统后,在浏览器访问:http://服务器IP:7860

页面布局

┌─────────────────────────────────────────────────────────┐

│ MagicTryOn 虚拟试穿系统 │

├─────────────────────────────────────────────────────────┤

│ GPU 内存模式: [纯GPU模式 ▼] │

├──────────────────┬──────────────────────────────────────┤

│ │ │

│ 输入参数区 │ 结果展示区 │

│ │ │

│ [上传图片] │ [试穿结果图片/视频] │

│ [设置参数] │ │

│ [生成按钮] │ │

│ │ │

└──────────────────┴──────────────────────────────────────┘

页面标签

- 快速试穿: 最简单的方式,上传原始图片即可

- 图片试穿: 使用预处理数据进行图片试穿

- 视频试穿: 使用预处理数据进行视频试穿

- 自定义试穿: 高级功能,包含预处理工具

三、快速试穿(推荐新手)

快速试穿是最简单的使用方式,只需上传原始图片,系统会自动完成所有预处理工作。

使用步骤

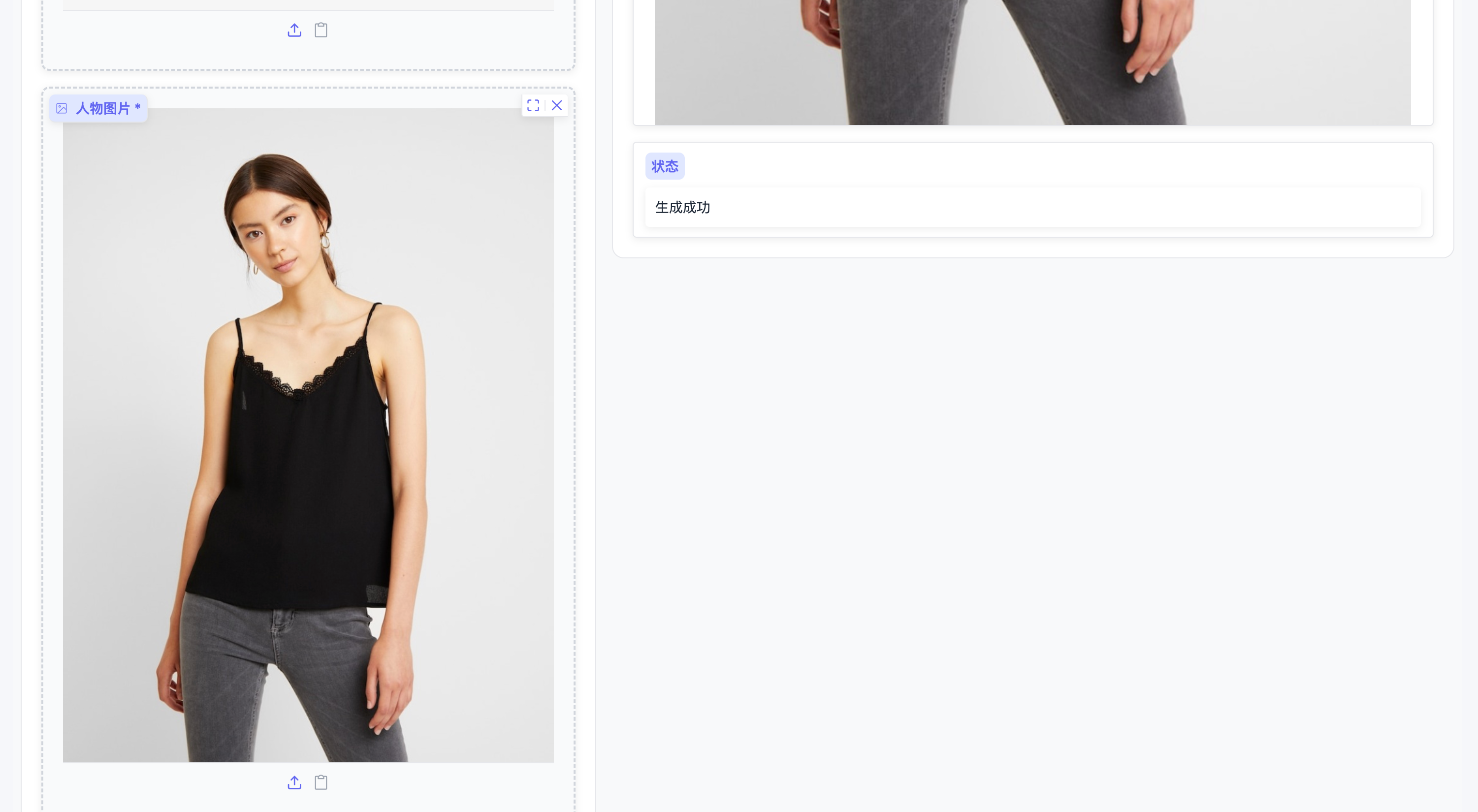

第一步:上传图片

- 点击 "快速试穿" 标签

- 上传 衣服图片(想要试穿的衣服)

- 上传 人物图片(模特/人物照片)

- 选择 衣服类型:

- 上装 (upper_body) - 衬衫、T恤、外套等

- 下装 (lower_body) - 裤子、裙子等

- 连衣裙 (dresses)

第二步:开始预处理

点击 "1. 开始预处理" 按钮

系统会自动:

- 生成 mask(衣服区域分割)

- 生成 agnostic person(去衣服后的人物)

- 生成 cloth line(衣服线稿)

时间: 约 30-60 秒

显存管理: 系统会自动卸载 14B 模型,预处理后自动释放预处理模型

第三步:设置生成参数(可选)

您可以调整以下参数:

| 参数 | 说明 | 推荐值 |

|---|---|---|

| 正面提示词 | 描述想要的试穿效果 | 必填 |

| 负面提示词 | 描述不想要的效果 | 已预填 |

| Guidance Scale | 引导系数(1-10) | 3.0 |

| 推理步数 | 生成质量(10-50) | 20 |

| 随机种子 | -1为随机,固定值可复现 | 43 |

| Repaint后处理 | 混合生成结果与原图 | 开启 |

第四步:开始生成

点击 "2. 开始生成试穿结果" 按钮

时间: 约 1-3 分钟

注意: 生成时系统会自动重新加载 14B 模型

第五步:查看结果

生成完成后,右侧会显示试穿结果图片。可以下载或继续尝试其他参数。

四、图片试穿

图片试穿适用于已有预处理数据的场景。

必需输入

- 衣服图片: 要试穿的衣服图片

- 人物图片: 原始人物图片

- Agnostic Person: 去除衣服后的人物图片(必需)

- Mask: 衣服区域分割 mask(必需)

- DensePose: 姿态热力图(必需)

可选输入

- Cloth Line: 衣服线稿图片(提高质量)

参数设置

与快速试穿相同。

五、视频试穿

视频试穿可以为视频序列生成虚拟试穿效果。

必需输入

- 衣服图片: 要试穿的衣服图片

- 人物视频: 原始人物视频

可选输入

- Mask 视频: 衣服区域分割视频

- Pose 视频: 姿态热力图视频

- Cloth Line: 衣服线稿图片

额外参数

- 视频长度: 生成视频的帧数,默认 16 帧,范围 1-49

六、自定义试穿

自定义试穿适用于高级用户,包含预处理工具引导。

预处理步骤

在使用自己的视频之前,需要先进行预处理:

方法一:使用预处理工具(需要命令行操作)

-

提取视频帧

ffmpeg -i video.mp4 images/%04d.png -

生成 Mask(试穿区域遮罩)

python inference/customize/gen_mask/app_mask.py -

生成 DensePose(人体姿态估计)

bash inference/customize/detectron2/projects/DensePose/run.sh -

组装视频

python inference/customize/image2video.py

方法二:使用 WebUI 预处理按钮

点击相应的预处理按钮:

- 提取视频帧:将视频分解为图片序列

- 生成 Mask:创建试穿区域遮罩

- 生成 DensePose:提取姿态信息

- 一键预处理:自动执行所有步骤

注意:预处理功能需要命令行工具支持,WebUI 会提供相应的命令提示。

七、GPU 内存模式

根据您的显卡显存大小,选择合适的模式:

| 显存 | 推荐模式 | 说明 |

|---|---|---|

| 48GB | 纯GPU模式 | 所有模型常驻 GPU,速度最快 |

| 24GB | CPU按需卸载 | 组件按需在 CPU/GPU 间转移 |

| 16GB | 模型完整卸载 | 完整模型在 CPU/GPU 间转移 |

| 12GB | FP8量化+卸载 | FP8 量化 + CPU 卸载 |

注意:

- 快速试穿功能会自动管理显存,无需手动调整

- 切换模式需要重新加载模型

八、参数说明

Guidance Scale(引导系数)

- 作用: 控制生成结果对提示词的遵循程度

- 范围: 1.0 - 10.0

- 默认: 3.0

- 建议:

- 增大值:更严格遵循提示词,但可能过度饱和

- 减小值:更自然,但可能偏离提示词

推理步数(Inference Steps)

- 作用: 控制生成质量

- 范围: 10 - 50

- 默认: 20

- 建议:

- 步数多:质量更高,但耗时更长

- 步数少:速度更快,但质量可能下降

随机种子(Seed)

- 作用: 控制生成的随机性

- 默认: 43

- 使用:

- 相同种子 = 相同输入会得到相同结果

- 设置为 -1 = 每次生成不同结果

Repaint 后处理

- 作用: 将生成结果与原始人物混合

- 默认: 开启

- 建议: 保持开启可以获得更自然的效果

九、提示词编写技巧

正面提示词

描述您想要的效果:

✅ 好的示例:

- "model is wearing a stylish white shirt"

- "fashion photo, high quality, detailed"

- "professional photography, good lighting"

❌ 避免使用:

- "man"(当人物是女性时)

- 过于复杂的描述

负面提示词

描述不想要的效果(已有很好的默认值):

默认值包含:

- 低质量、模糊、变形

- 多余的手指、肢体

- 静止、过曝、色调艳丽

十、常见问题

Q1: 生成结果中衣服没有正确替换?

A: 请确保使用"快速试穿"功能,它会自动生成所需的预处理数据。

如果使用"图片试穿",请确保上传了 Agnostic Person、Mask 和 DensePose。

Q2: 生成速度很慢?

A: 这是正常的,14B 模型推理需要时间。可以尝试:

- 降低推理步数(如 10 步)

- 检查 GPU 内存模式是否合适

- 关闭 Repaint 后处理

Q3: 显存不足错误?

A: 请选择更低的 GPU 内存模式,如"CPU按需卸载"。

Q4: 快速试穿的预处理失败了?

A: 请确保:

- 图片格式正确(JPG/PNG)

- 衣服类型选择正确

- 图片清晰,人物完整可见

Q5: 如何获得更好的生成效果?

A:

- 使用高质量的输入图片

- 编写合适的正面提示词

- 适当调整 Guidance Scale

- 增加推理步数(如 30 步)

Q6: 图片试穿需要哪些预处理数据?

A: 图片试穿需要以下必需数据:

- Agnostic Person: 去除衣服后的人物图片

- Mask: 衣服区域分割(白色=衣服区域,黑色=背景)

- DensePose: 姿态热力图

如果没有这些数据,请使用"快速试穿"功能。

十一、输出文件

保存位置

所有生成的结果保存在 outputs/ 目录下。

文件命名

每次生成会创建一个时间戳目录:

outputs/YYYYMMDD_HHMMSS/

├── result.png # 图片试穿结果

└── result.mp4 # 视频试穿结果

下载结果

- 点击结果图片/视频上方的下载按钮

- 或直接从

outputs/目录复制

十二、使用建议

图片要求

衣服图片:

- 建议平铺图或模特展示图

- 衣服完整清晰

- 背景简洁

人物图片:

- 人物完整可见

- 姿势自然站立

- 光线均匀

最佳实践

- 第一次使用: 建议从"快速试穿"开始

- 质量优先: 使用高质量的输入图片

- 参数调整: 先用默认参数,再根据效果微调

- 耐心等待: 模型加载和生成需要时间

十三、文件格式支持

图片格式

- 支持格式:JPG、PNG、WEBP

- 建议大小:不超过 10MB

- 建议分辨率:512x512 以上

视频格式

- 支持格式:MP4、AVI、MOV

- 建议大小:不超过 100MB

- 建议帧率:24-30 FPS

十四、快捷操作

图片上传

- 支持拖拽上传:直接将文件拖到上传框

- 支持点击上传:点击上传框选择文件

- 支持粘贴上传:复制图片后直接在输入框粘贴(Ctrl+V)

参数记忆

系统会记住上次使用的参数值,方便重复使用相同设置。

十五、处理时间参考

| 功能 | 预计时间 |

|---|---|

| 快速试穿-预处理 | 30-60 秒 |

| 快速试穿-生成 | 1-3 分钟 |

| 图片试穿 | 10-30 秒 |

| 视频试穿(16帧) | 1-5 分钟 |

注:时间取决于 GPU 性能和参数设置

十六、版权声明

WebUI 二次开发 by 科哥 | 微信:312088415

承诺永远开源使用 但是需要保留本人版权信息!

用户手册版本: 2.0 最后更新: 2026-01-03

认证作者

认证作者

支持自启动

支持自启动