ComfyUI_FlashVSR 实时视频超分,支持1分钟以上视频超分

实时视频超分项目,显存如果够大,所有视频超分到4K

8

80元/小时

v1.3

ComfyUI_FlashVSR 实时视频超分

v1.3版更新

- 新增flashVSR1.1版本模型,画质更好,保真度更高,只需要底模和Q模型替换,其他不用,模型已经内置,无效重新下载;

- 新增vae 解码多种选项,包括2倍放大解码输出,比如你正常缩放到2K,再由vae解码2倍放大,但是该vae效果一般;以及lightx2v的 加速vae,菜单选择decode vae开启,选择为none时不开启

- ComfyUI使用:图文指南

既往更新

- 新增lucidflux 图片超分修复节点

- flashSVR 同步循环超分功能,同步long mode 同步显存优化功能

- 循环超分节点,可以无限跑,需要手动输入存储切分好的图片的路径

Tips

- 非KJ的魔改版,百分比复现官方

- Block-Sparse-Attention库的完全体加速,正常1024*768 1倍放大只需要12G,推理只需几十秒

推荐使用方法 :

- 1、原本就是小视频,比如720以下的老视频,直接scale放大2倍或者4倍;

- 2、1280*720视频,放大2倍需要48G的显存,所以可以试着先等比例缩小视频(节点的高宽可以中心缩放),再2倍放大

- 3、有钱的直接上A100 超分4K视频

- 4、lucidflux的使用看我的视频,或者用默认工作流

- 5、推理时长过时,也会OOM。一次性推理十分钟的视频,得上超大显存

- 6、 vae的full 模式效果比tiny要好,但是更吃资源,

- 7、在不OOM的情况下,关闭tile可以获得更好的效果

- 8、使用12G显存的时候, lucidflux要使用fp8模型

其他细节可以去我B站账号留言或私信:smthem

镜像使用流程

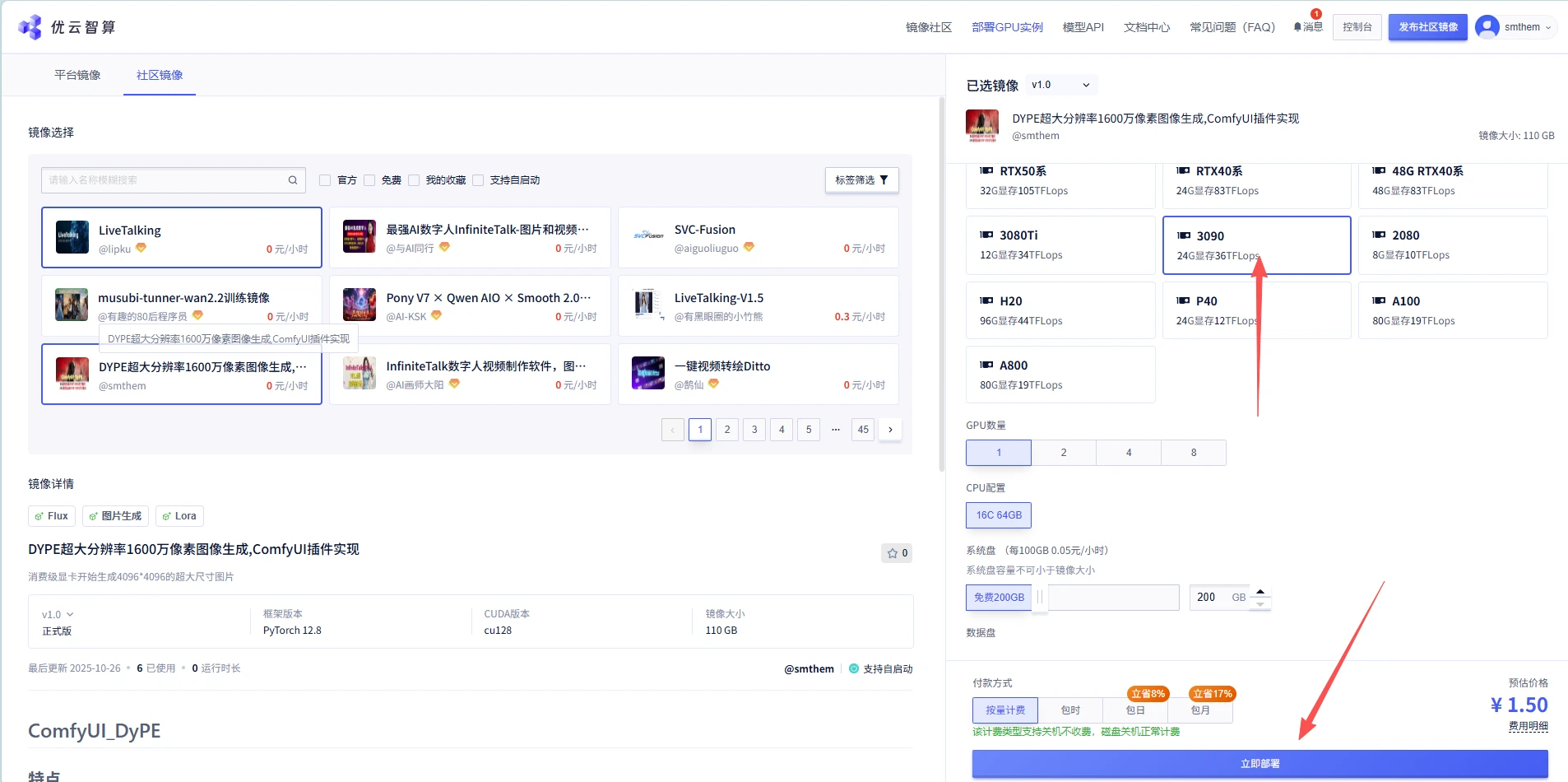

第1步:选择本镜像创建,选一个GPU,视财力而定,点击右下角的立即部署按钮

第2步:点选部署后,会跳转页面到你的控制台,这里会出现刚才你选择的实例,等实例加载和初始化完成

第3步:实例初始化完成后,会出现comfyUI图标,点选,左边的JupyterLab只是方便你上传和下载模型及文件,或者修改代码

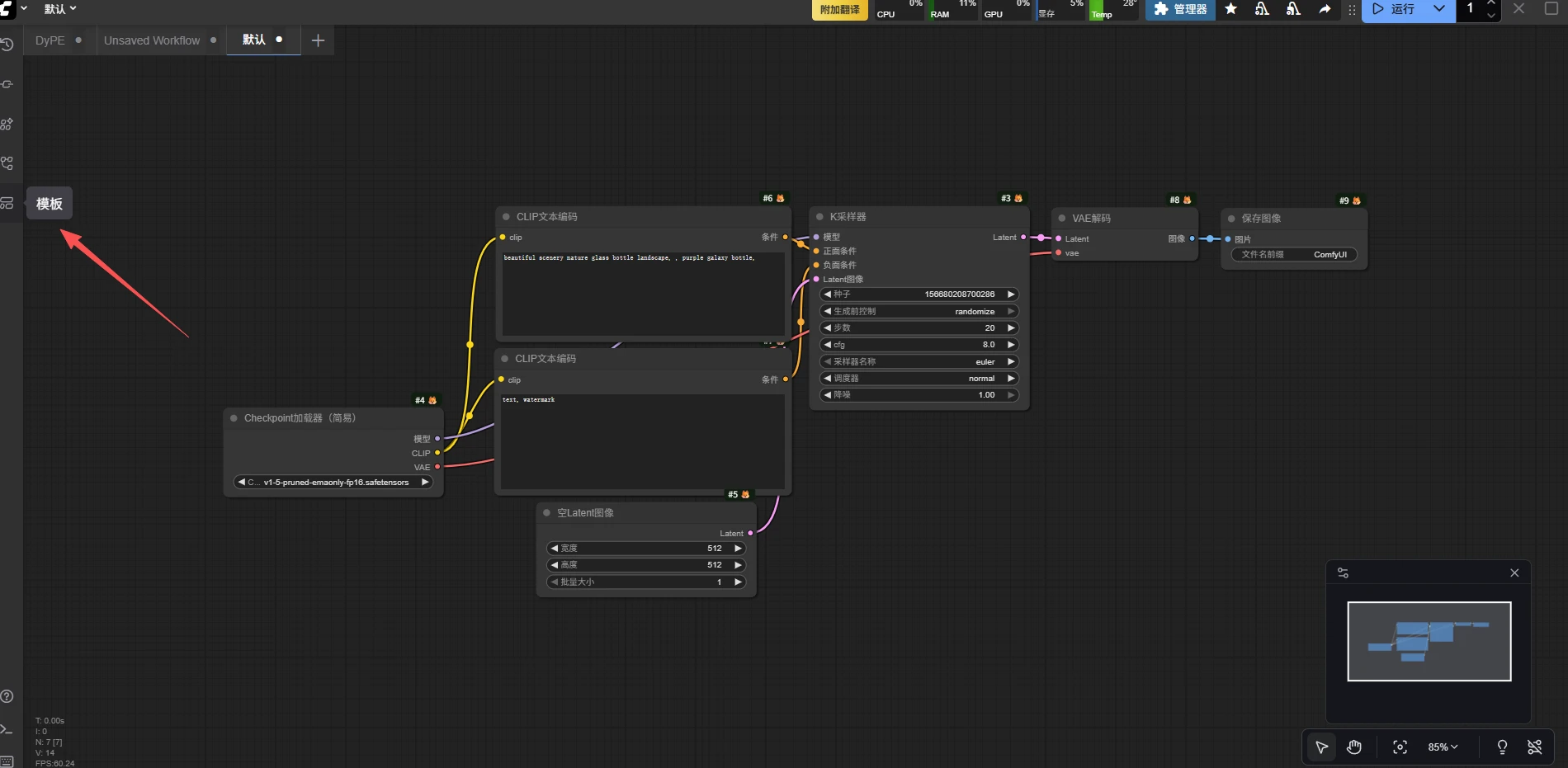

第4步:点选comfyUI后,浏览器会跳转comfyUI页面,如下,一般是默认的流,所以点选左边箭头所示的模板

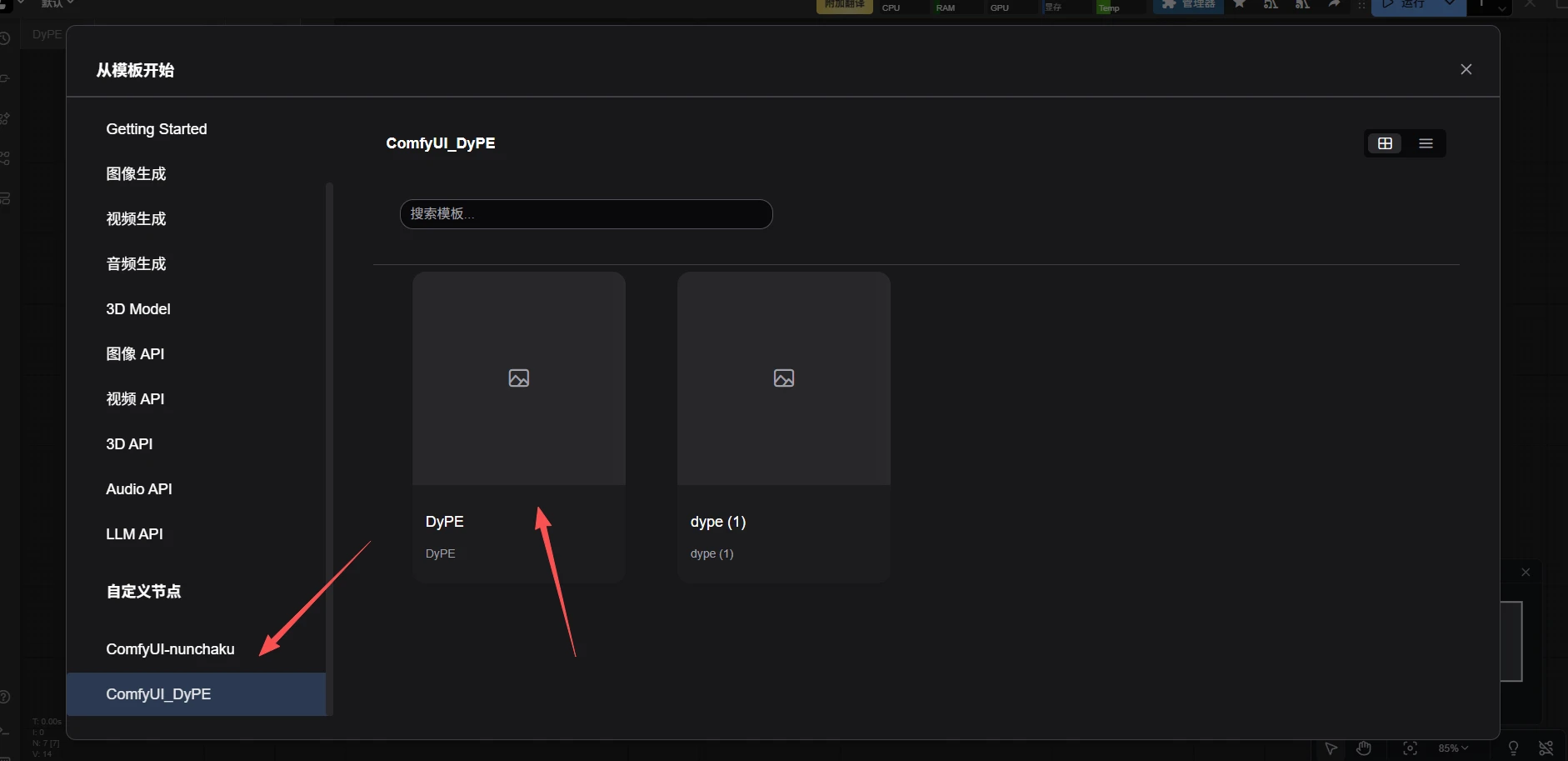

第5步:选择模板最下面插件名,并左侧大写的工作流(箭头),即可跳转

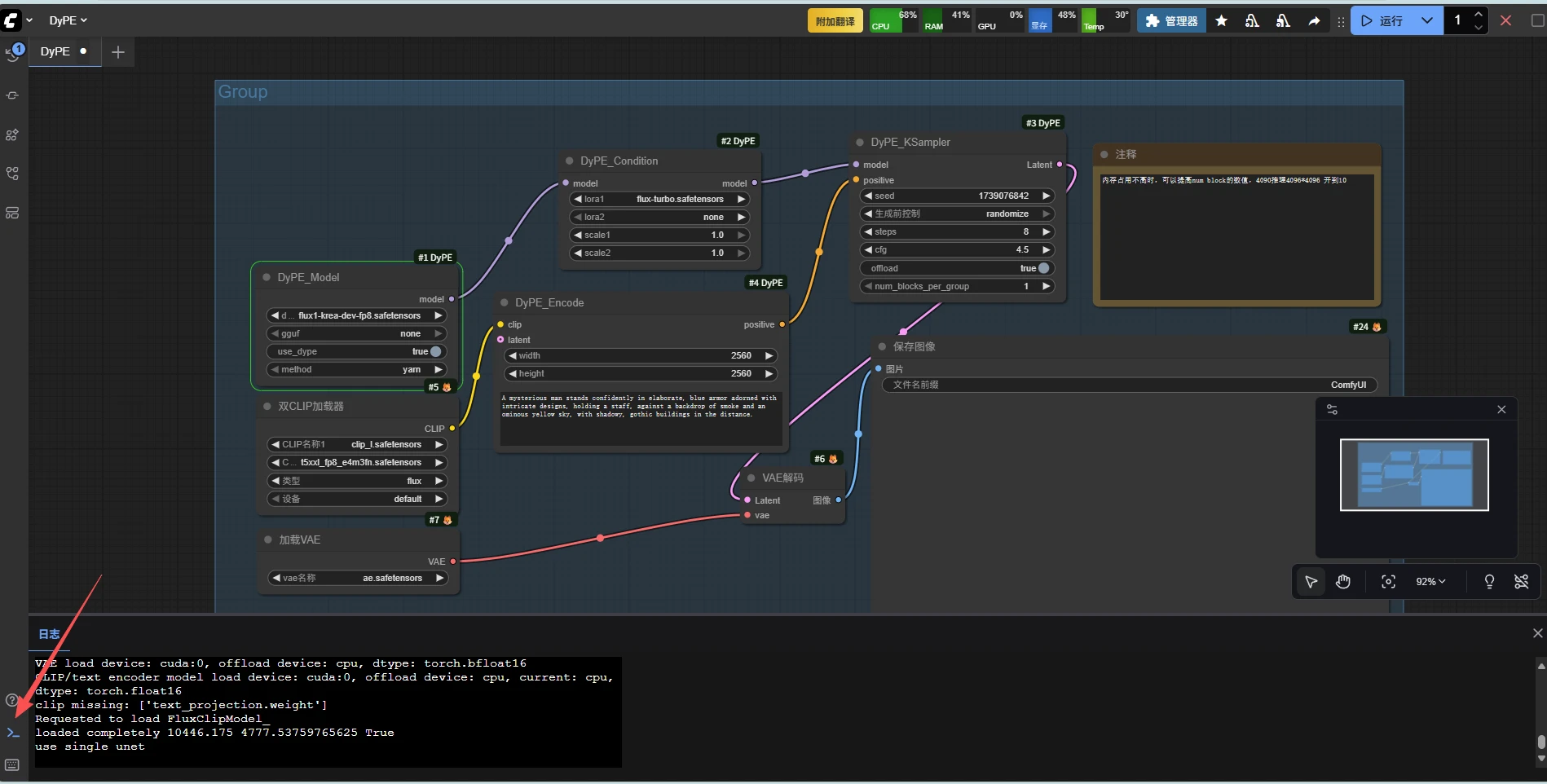

第6步:跳转工作流后,只需要修改你要生成的图片尺寸,修改你想要的prompt,点击运行即可

第7步:运行完成后,选择图片,右键保存图片,即可下载到本地。点选左下角箭头所指图标,可以看运行的控制台

第8步:如果运行的时候内存OOM导致comfyUI挂掉,可以去控制台重启

第9步: 如果不再推理了,为了省钱,记得一定要关闭实例,点击关闭后,有个弹窗,点击确认才有效(防误触)

@smthem

镜像信息

已使用136 次

运行时长

137 H

支持自启动

支持自启动镜像大小

100GB

最后更新时间

2025-11-27

支持卡型

RTX40系48G RTX40系3080Ti3090H20P40A100A800V100S

+9

框架版本

CUDA版本

cu128

应用

JupyterLab: 8888

版本

v1.3

2025-11-27