1

1vLLM-Omni

镜像介绍

近年来,生成式人工智能领域经历了从单一文本生成向多模态融合的根本性转变。以GPT-4o、Qwen-Omni为代表的新一代模型,已经具备了同时理解和生成文本、图像、音频、视频的能力。这种能力的背后是模型架构的根本性变革:从单一的自回归Transformer,演变为由编码器、语言模型、扩散模型等多个异构组件组成的复杂系统。

传统的推理引擎在面对这类多模态模型时暴露出明显的局限性。首先,它们通常假设输入输出均为文本序列,无法有效处理图像张量、音频波形等异构数据类型。其次,自回归模型的调度策略并不适用于扩散模型等并行生成架构,导致GPU资源利用率低下。更为关键的是,当一次推理请求需要经过"视觉编码-语言理解-图像生成"等多个阶段时,缺乏统一的调度机制会使整个流水线难以优化。

镜像使用指南

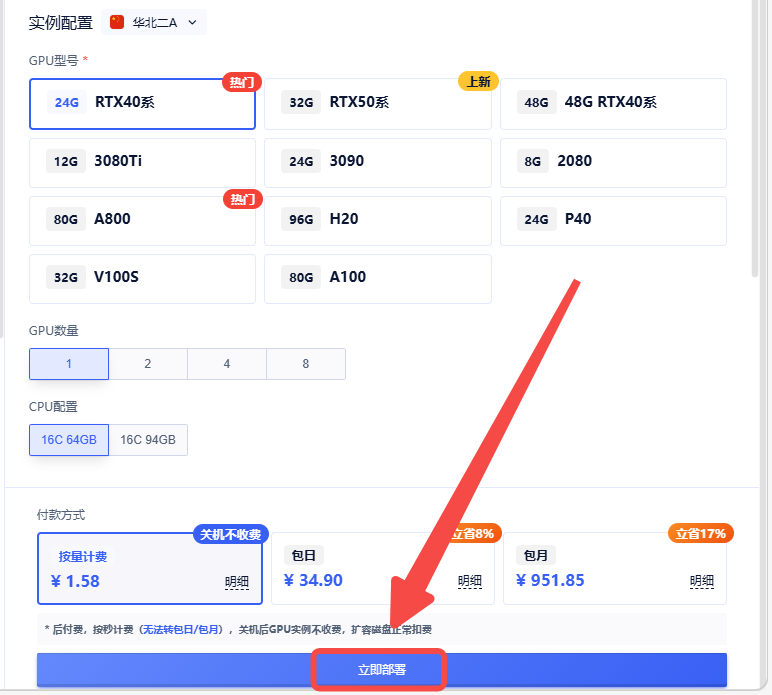

1.创建实例

2.选择合适的机型,立即部署

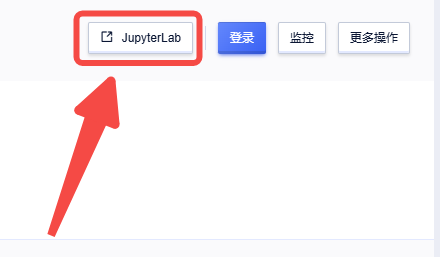

3.返回实例页面,点击【JupyterLab】进入文件夹

vLLM-Omni针对多模态推理场景设计了异构流水线架构。一个典型的全模态推理请求会经过以下三类处理组件:

模态编码器(Modality Encoders):负责将多模态输入转换为模型可处理的向量表示。对于图像输入,通常采用Vision Transformer(ViT)进行编码;对于音频输入,则使用Whisper等语音编码器。编码器的输出是固定维度的特征向量,作为后续语言模型的输入。

语言模型核心(LLM Core):基于vLLM的自回归文本生成模块,负责理解多模态上下文并生成响应。这一阶段充分利用了vLLM在文本推理方面的优化成果,包括PagedAttention、连续批处理等技术。

模态生成器(Modality Generators):用于生成非文本输出的解码组件。对于图像生成,通常采用扩散模型(Diffusion Model)或扩散Transformer(DiT);对于音频生成,则使用神经声码器将语义token转换为音频波形。

该文件夹为使用 vLLM-Omni 进行 Qwen/Qwen-Image 实验提供了两个简单的入口,使用下面内容可以用于单一图像生成的命令行脚本。值得一提这类示例代码模型都是比较大的,作者使用A800作为示例,当然用户可以自定义模型后续

python vllm_omni_gradio_app.py --prompt "a cup of coffee on the table" --seed 42 --cfg_scale 4.0 --num_images_per_prompt 1 --num_inference_steps 50 --height 1024 --width 1024 --output outputs/coffee.png

认证作者

认证作者